Der Unterschied zwischen der Zensur der Medien in Diktaturen und der Pressefreiheit in den Demokratien besteht darin, dass die Zensur in den Diktaturen unbestritten ist.

Der CO2 - Skandal

Die Demonstrationen der "Letzten Generation" ließen sich leicht vermeiden, wenn es die Bundesregierung ermöglichen würde. der Bevölkerung mitzuteilen, dass wissenschaftlich unstrittig nachgewiesen ist, dass CO2 nicht für die derzeitige Erderwärmung verantwortlich ist. Siehe auch die Begründung weiter unten.

Darüber hinaus würden auch die Aktivitäten der "Friday for Future" eingestellt, wenn die Physiklehrer entsprechend dem Lehrplan für Physik der Oberstufen, ihren Schülern die drei Hauptsätze der Wärmelehre erklären würden, denn die Vermittlung von Lehrninhalten gehört schließlich zu ihren Hauptaufgaben. Ansonsten müssten die Demonstrationen in "Friday for Stupids" umbenannt werden.

Interessant wäre es auch, wenn die frühere Umweltministerin und spätere Klimakanzlerin, Frau Dr. Angela Merkel, eine diplomierte und promovierte

Physikerin, der Öffentlichkeit erklären würde, warum sie die physikalischen Gesetze ignoriert und sich für die falschen Behauptungen der Ideologen eingesetzt hat, unter denen wir heute leiden.

Ende des Klimatextes

********************************************************************************************************************

Kosmologie: Warum der Urknall eine unhaltbare Theorie ist..

********************************************************************************************************************

Friday for Stupids!

Da die Physiklehrer ganz offensichtlich nicht die Dienstordnung befolgen, ist zu überprüfen, ob hier nicht der Tatbestand der Arbeitsverweigerung zum Schaden der Bevölkerung vorliegt.

Allgemeine Dienstordnung für Lehrer und Lehrerinnen, Schulleiter und Schulleiterinnen an

öffentlichen Schulen (ADO)

- Es gehört zum Beruf der Lehrer und Lehrerinnen, in eigener Verantwortung und pädagogischer Freiheit die Schüler und Schülerinnen zu erziehen, zu unterrichten, zu beraten und zu beurteilen. Dabei ist der Bildungs- und Erziehungsauftrag der Schulen nach Verfassung und Schulgesetzen zu beachten.

Würden die Schüler entsprechend der oben angeführten Dienstordnung unterrichtet, Beweis weiter unten, würden sich die Schüler auch nicht von interessierten Kreisen missbrauchen lassen.

Der wissenschaftliche Beweis,

dass CO2 nicht für den Klimawandel verantwortlich ist.

Eine Blamage sowohl für die Medien, die Politiker und das Bildungswesen.

Würde die Öffentlichkeit seriös informiert und würden die Schüler pflichtgemäß unterrichtet, gäbe es keinen „Friday for Future“. So ist aber die Bezeichnung irreführend, denn es handelt sich in Wahrheit, um einen „Friday for Stupids“.

Aus diesem Grunde sind der Emissionshandel mit CO2 Zertifikaten und die beabsichtigte CO2 Steuer ein Schildbürgerstreich. Man kann nur hoffen, dass durch Gerichtsentscheide dieser grobe und in jeder Beziehung schädliche Unfug verboten wird. So kann allein schon aus formalen Gründen eigentlich keine CO2 Steuer erhoben werden, denn in Deutschland gibt es lediglich Verbrauchs-, Aufwands- oder Verkehrssteuern. Zu keiner dieser Kategorien passt nach Einschätzung des wissenschaftlichen Dienstes die CO2 - Steuer. Eine CO2-Emission ist aber "weder der Verbrauch eines Verbrauchsguts" - da CO2 emittiert und nicht verbraucht wird -, es ist aber auch kein Rechts- oder Wirtschaftsvorgang oder der Besitz einer Sache. Wie die Experten schreiben, sieht der Steuertypenkatalog des Grundgesetzes zwar ein "Steuerfindungsrecht, aber gerade kein Steuererfindungsrecht" vor. (MDR.DE Wissenschaftlicher Dienst).

Der Philosoph Professor Dr. Klaus Fischer von der Universität Trier stellte bereits in: „Die politische Konstruktion der Universitätskrise - Siebzehn Thesen zu einer merkwürdigen Diskussion.“ (November 1997, 51. Jahrgang, Heft 584, pp 1003-1011) Folgendes fest.

Seine 7. These lautet: „Das deutsche System der Forschungsförderung ist nicht auf das Erkennen des Außergewöhnlichen, sondern auf die Belohnung des konsensfähigen Mittelmaßes angelegt.“

Die These 15 lautet: „Die Zwänge des „peer- reviewing – Systems“ führen zu einer Konvergenz der Meinungen, die nicht durch Fakten und Überzeugungen, sondern von der Notwendigkeit geleitet wird, Verbündete im Kampf um Forschungsmittel zu suchen.“

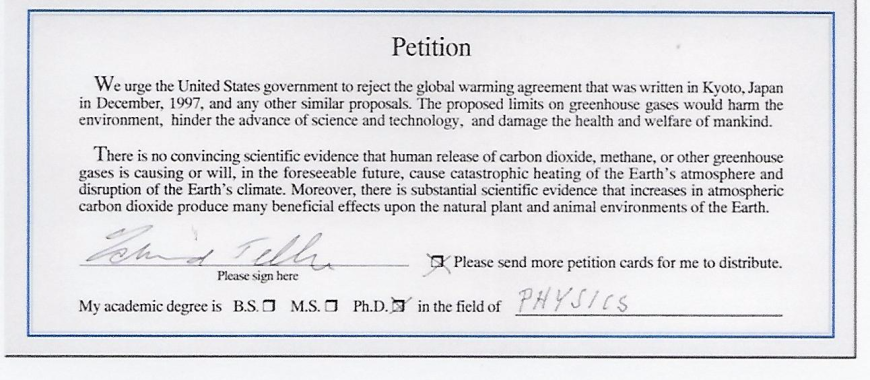

Es nützte auch nichts, als bereits am 13. März 2001 der US-Präsident George W. Bush erklärt hatte: „I oppose the Kyoto Protocol!“, da er nicht an die CO2 – Lüge glaubte. Damit löste er kurzzeitig einigen Wirbel aus. So schrieb das als Organ der Deutschen Wirtschaft geltende Handelsblatt am 27. März 2001: „Bush dreht die Uhr beim Klimaschutz zurück“ und die Börsenzeitung schrieb in ihrer Thomas-Gebert-Kolumne voller Optimismus: „Der Irrsinn hat ein Ende ….. .Jedenfalls hat Georg Bush, der in einer Unterschriftenaktion von 31.487 amerikanischen Wissenschaftlern genau dazu aufgefordert worden ist, uns vor einer riesigen Dummheit bewahrt und uns allen viele hundert Milliarden Dollar eingespart. Bravo, George!“

Global Warming Petition Project

31,487 American scientists have signed this petition,

including 9,029 with PhDs

Bereits 2001 wurden von drei deutschen Behörden, nämlich der Bundesanstalt für Geowissenschaften und Rohstoffe in Hannover (eine nachgeordnete Behörde des Bundeswirtschaftsministeriums), dem Institut für Geowissenschaftliche Gemeinschaftsaufgaben und dem Niedersächsischen Landesamt für Boden-forschung, die Erkenntnisse ihrer wissenschaftlichen Mitarbeiter durch die Autoren Ulrich Berner und Hansjörg Streif in Buchform auf 238 Seiten dargelegt und veröffentlicht. Die Wissenschaftler dieser Behörden kamen im Hinblick auf den Zusammenhang zwischen der Zunahme des Treibhausgases CO2 und der Erderwärmung in den letzten 150 Jahre zu der Schlußfolgerung, dass „die beobachteten Temperaturanstiege bzw. -abnahmen ohne Bezug zu CO2 erfolgten.“ Das Buch erschien 2001 im Stuttgarter Fachverlag E. Schweizerbart unter dem Titel „Klimafakten. Der Rückblick - Ein Schlüssel für die Zukunft“.

Der Verlag schreibt zu dem Buch: „Wenige Themen nehmen heute in Politik und Medien ähnlich breiten Raum ein wie Klima - Klimaänderungen - Klimakatastrophen. Meist geht es dabei um mögliche Auswirkungen menschlicher Eingriffe in das Klimasystem. Oft unterschätzt man allerdings das Ausmaß und die Dynamik natürlicher Klimaschwankungen. Rückblickend auf die Erdgeschichte legen Geowissenschaftler im vorliegenden Sachbuch ihr umfangreiches Wissen über das Klima vergangener Zeiten vor. Aus den hinterlassenen Gesteinen, dem Grundwasser und dem Eis großer Gletscher gewinnen sie eine Fülle von Informationen, wie z.B. über Wassertemperaturen ehemaliger Ozeane, die Luftfeuchtigkeit bzw. Trockenheit untergegangener Kontinente oder die Gaszusammensetzung einer früheren Atmosphäre. Dieser Rückblick ist gleichzeitig auch ein Schlüssel für die Zukunft, weil er eine Bewertung der verschiedenen im Klimasystem wirksamen Faktoren erlaubt. Hervorzuheben ist dabei, dass nicht das oft zitierte Kohlendioxid bestimmender Faktor des Klimageschehens ist. Vielmehr treibt die Sonne wie ein Motor die klimawirksamen Prozesse in der Atmosphäre, den Ozeanen und in der Biosphäre an. Zahlreiche Belege aus der Natur sprechen für eine wahre "Achterbahnfahrt" des Klimas durch die Erdgeschichte. Wer mehr zum Thema Klima erfahren möchte, findet in diesem Buch umfassende, auch dem Laien verständliche Informationen. In anregender Form sprechen die Autoren offene Fragen an und vermitteln neue Denkanstöße. Erstmalig wird hier aus der Sicht der Geowissenschaft Stellung zur aktuellen Klimadiskussion bezogen. Mit dem hier vorgelegten, erheblich erweiterten Hintergrundwissen sind viele bisher getroffene Aussagen zum Thema Mensch und Klima höchst kritisch zu bewerten.“

Auch beim 58. Nobel Laureate Treffen in Lindau vom 29.06. - 04.07.2008 wurde durch den Vortrag des Klimaforschers von Dr. David Evans auf Grund fundierter Forschungsergebnisse der Nachweis erbracht, dass CO2 – nicht für die derzeitige Klimaerwärmung verantwortlich ist, wie interessierte Kreise glaubhaft machen wollen.

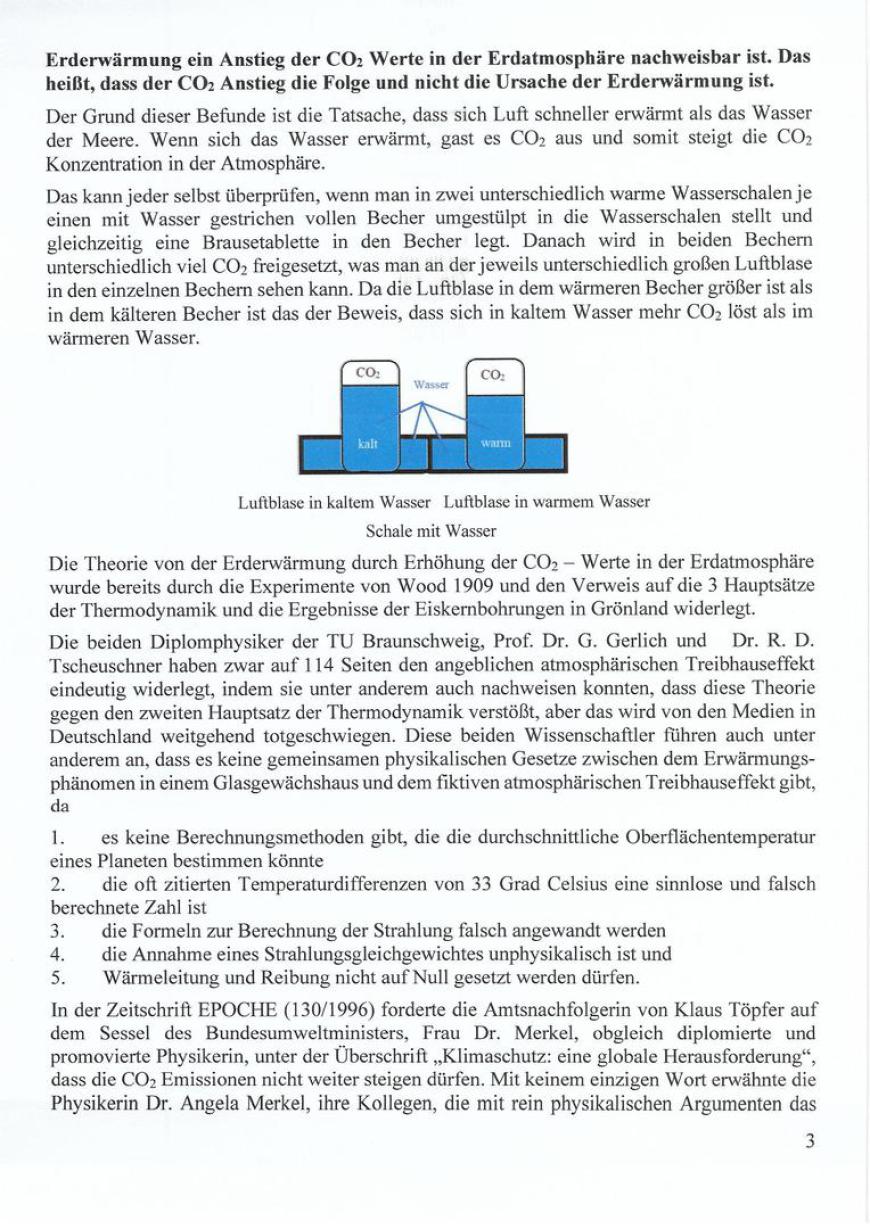

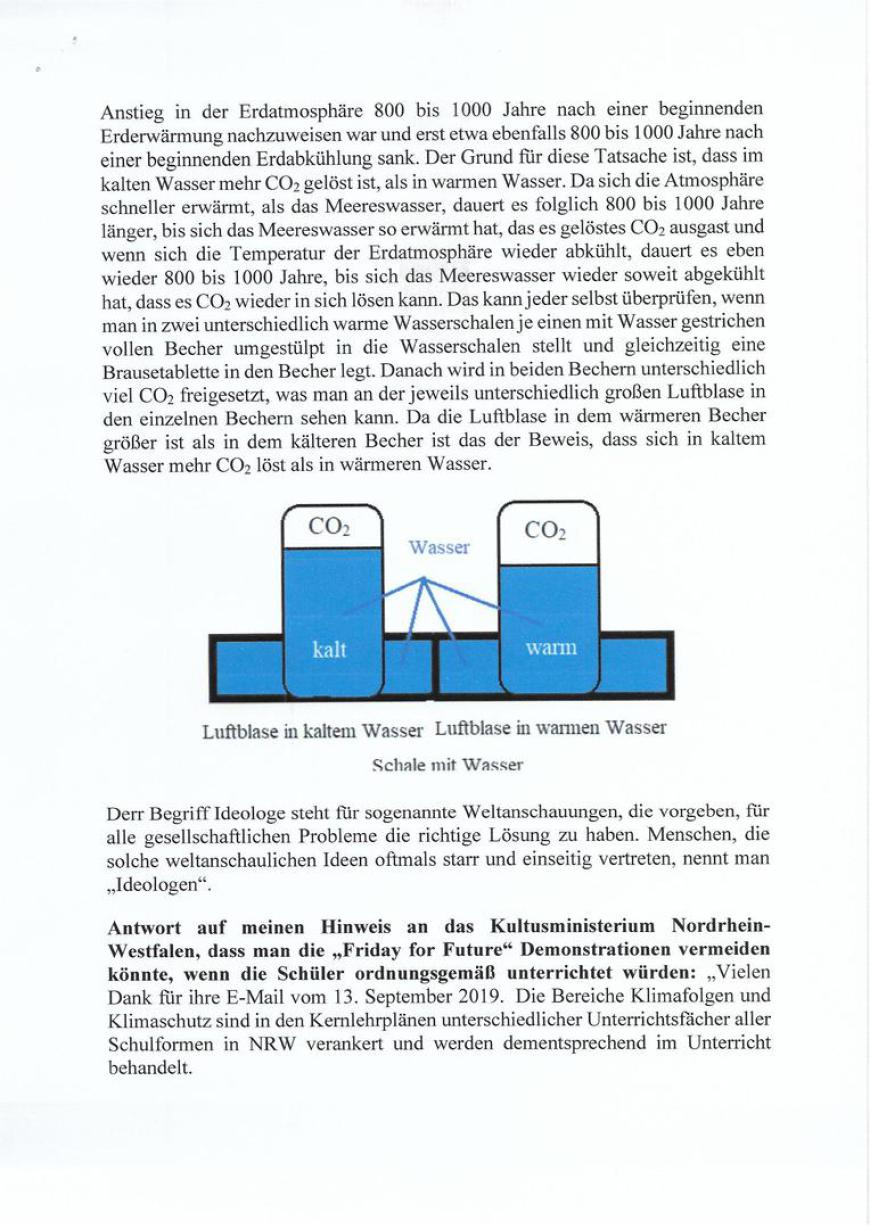

In seinem Vortrag „No smoking hot spot“ führte Dr. David Evans damals aus, dass die Ergebnisse der Eiskernbohrungen in der Antarktis und auf Grönland bezeugen, dass Temperaturerhöhungen im Durchschnitt 800 Jahre früher auftraten als der Anstieg des CO2 - Niveaus. Der späte Anstieg der CO2 - Werte beruhe darauf, dass sich die Erdatmosphäre schneller erwärmt, als das Wasser in den Meeren. Wenn sich Wasser erwärmt, wird das im Wasser gelöste CO2 freigesetzt und an die Erdatmosphäre abgegeben. Wenn sich die Atmosphäre zu einem späteren Zeitpunkt wieder abkühlt, kühlt sich entsprechend später das Wasser der Meere wieder ab und CO2 löst sich wieder aus der Erdatmosphäre. Der CO2 - Wert in der Erdatmosphäre sinkt folglich auch. Das sagt eigentlich alles über Ursache und Wirkung!

Die Öffentlichkeit und unsere Politiker kennen offensichtlich nicht die maßgebenden Zusammenhänge und Fakten: Denn keiner der von Dr. Evans erwähnten Punkte ist umstritten. Selbst die Klimaalarmisten stimmen ihnen zu, bezweifeln aber ihre Bedeutung.

Eine offene Diskussion zu diesem Thema wurde in den letzten 18 Jahren zu keinem Zeitpunkt geführt, die Öffentlichkeit wurde gebetsmühlenhaft von allen Medien und Parteien einseitig informiert und mit Panikmache, statt Durchsetzung gesicherter seriöser und effektiver Maßnahmen, riesige Geldsummen „verbrannt“.

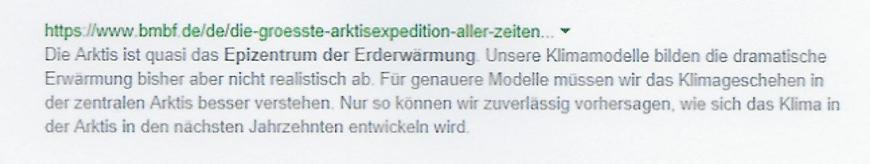

Selbst das Bundesministerium für Bildung und Forschung stellte fest.

Kurz wir haben Zustände wie zur Zeit der Inquisition, allerdings ist die Vorgehensweise optimiert worden und weltweit wird die Menschheit indoktriniert. Dabei lässt sich allein mit dem gesunden Menschenverstand nachweisen, dass CO2 nicht für die Klimaerwärmung verantwortlich sein kann.

Es wundert mich, warum in Deutschland offensichtlich die Physiklehrer nicht ihren Pflichten nachkommen und auch kein Kultusministerium seiner Fachaufsicht nachkommt. Stattdessen verurteilt man die Protestbewegung der Schüler. Wenn die Schüler im Unterricht mit den Gesetzen der Thermodynamik vertraut gemacht worden wären, wären sie auch nicht auf die Straße gegangen. Bei der Protestbewegung „Friday for Future“ handelt es sich deshalb um “Friday for Stupids“, weil Medien, Politiker und Lehrer sträflich versagt haben. Offensichtlich wird von der Bundesregierung der § 5 des Grundgesetzes nur als Absichtserklärung verstanden, denn ansonsten hätten schon längst juristische Schritte gegen diese Indoktrinierung der Bevölkerung unternommen werden müssen.

Zurzeit werden 419 ppm CO2 in der Erdatmosphäre nachgewiesen. Das bedeutet in Zahlen, dass auf 100.000 Luftmoleküle 41,9 CO2 Moleküle kommen. Eine derart geringe Zahl an dem Spurenelement CO2 kann weder eine geschlossene CO2 Schicht bilden, wie die Scheiben in einem Gewächshaus, noch besitzen sie eine derartige „Heizkraft“ mit den re-reflektierten Infrarotstrahlen des Erdbodens um die Atmosphäre zu erwärmen.

Die Erde nimmt Strahlungsenergie von der Sonne auf und reflektiert einen Teil der Strahlungsenergie in Form von langwelligerer Wärmestrahlung in den Weltraum. Die einzelnen CO2 Moleküle sind sporadisch in der Erdatmosphäre verstreut und absorbieren einen geringen Teil dieser Erdwärmestrahlung, um sie dann erneut nach allen Seiten abzugeben. Das bedeutet, dass lediglich weniger als die Hälfte dieser aufgenommenen geringen Wärmeenergie überhaupt erneut zur Erde re-reflektiert wird.

CO2 kann mangels geeigneter Absorptionslinien das atmosphärische „Strahlungsfenster“ nicht schließen und hat daher keinen Einfluss auf das Wetter, auf das Klima! Anders formuliert: Es ist physikalisch unmöglich, dass ein „Schwarzer Körper“, der kontinuierlich über ein breites Wellenlängenspektrum Energie abstrahlt, von einer atmosphärischen Gashülle, die nur selektiv, vereinzelt und diskret Strahlung absorbiert, an seiner Abkühlung gehindert, geschweige denn erwärmt werden könnte.

Meteorologisches Elementarwissen: Die tagsüber vom Erdboden aufgenommene Energie entschwindet nachts bei klarem Himmel unsichtbar und ungehindert „direkt“ mittels „Temperaturstrahlung“ wieder in den Weltraum. Insbesondere die CO2 -Moleküle mit ihren besonderen stoffspezifischen Absorptionsbanden bei 2,8 m, 4,5 m und 15 m, die so unabänderlich und charakteristisch sind wie ein menschlicher „Fingerabdruck“, haben auf den täglichen Temperaturverlauf keinen Einfluss, weil sie das „offene Strahlungsfenster“ zwischen 7 m und 13 m nicht schließen können. Dies würde auch dann gelten, wenn die Erde von einer reinen CO2 -Atmosphäre umgeben wäre. Es kann also aus rein physikalischen Axiomen heraus keinen wie auch immer gearteten „Wärmestau“ unter dem fiktiven „Glasdach“ in 6 km Höhe geben. Der „Treibhauseffekt“ ist eine pure Erfindung interessierter Kreise, die Mathematiker beauftragten, für ihre Interessen geeignete Klimamodelle zu errechnen. Mathematiker rechnen „Wenn“ > „Dann“.

Man kann deshalb durch entsprechende Vorgaben ein erwünschtes Ergebnis mathematisch konstruieren. Sind aber die Vorgaben falsch, kann das Ergebnis nicht richtig sein. Deshalb fordern seriöse Wissenschaftler, dass mathematische Berechnungen mit der Realität abgeglichen werden müssen. Selbst wenn man die Atmosphäre wegdenken und wie dereinst Svante Arrhenius bei seiner „Eiszeithypothese“ 1896 rein modelltheoretisch annehmen würde, dass der gesamte CO2-Gehalt der Atmosphäre wie ein „Schwarzer Körper“ in 6 km Höhe die Erde umhülle, selbst dann kann es keinen „Treibhauseffekt“ geben, denn die -18 C kalte „Kohlendioxidschicht“ würde mit einer Leistung von 240 W/m2 die Erde „anstrahlen“, während die +15 C warme Erde permanent Energie in der Größenordnung von 390 W/m2 abstrahlen würde. Der 2. Hauptsatz der Thermodynamik lässt prinzipiell nicht zu, dass Wärme von kalt nach warm fließt. Das gasförmige CO2 als „Treibhausgas“ zu bezeichnen, welches wie ein „Glasdach“ in einem Gewächshaus die Wärmestrahlung „reflektiert“ und am Entweichen in den Weltraum hindert, ist physikalisch unhaltbar. Auch Gewächshäuser kühlen nachts aus und müssen im Winter beheizt werden. Zur Strahlungsabsorption in diesem Bereich stellte bereits im März 1989 die Enquete-Kommission „Vorsorge zum Schutz der Erdatmosphäre“ in ihrem Zwischenbericht physikalisch korrekt fest: „Die Gase in der Atmosphäre absorbieren die Infrarot-Strahlung der Erdoberfläche in den meisten Spektralbereichen stark, in einigen dagegen nur geringfügig, wie etwa im Spektralbereich 7 bis 13 m. In diesem Bereich stammt der größte Anteil der IR-Strahlung von der Erdoberfläche. Er wird als „offenes atmosphärisches Strahlungsfenster“ bezeichnet, da hier am wenigsten Wasserdampf- und CO2-Absorption stattfindet. 70 % bis 90 % der Abstrahlung von der Erde gelangen hier direkt in den Weltraum.“

Enquete-Kommissionen sind vom Deutschen Bundestag oder einem Landesparlament eingesetzte überfraktionelle Arbeitsgruppen, die umfangreiche und bedeutsame Sachkomplexe lösen sollen, in denen unterschiedliche rechtliche, wirtschaftliche, soziale oder ethische Aspekte abgewogen werden müssen.

Bei wolkenlosem Himmel entweichen 70 % bis 90 % der im Erdboden gespeicherten Wärme ungehindert ins Weltall und im „Idealfall“ werden rein hypothetisch 10 % bis 30 % von den „Treibhausgasen“ absorbiert, um dann zur Erde „re-emittiert“ zu werden.

Eine „Erwärmung“ der Erde über die eigene wieder reflektierte Energie ist deshalb völlig ausgeschlossen! Damit bricht die Hypothese, die Erhöhung des CO2-Gehaltes in der Atmosphäre würde eine „Erderwärmung“ hervorrufen und eine „Klimakatastrophe“ zur Folge haben, die nur durch eine drastische Reduzierung der „CO2 -Emissionen“ verhindert werden könnte, in sich zusammen. Deshalb sind der Handel mit Emissionszertifikaten und die Besteuerung von CO2 – Ausstoß ein ungeheuerlicher und willkürlicher Eingriff in die Wirtschaftspolitik, ganz davon abgesehen, dass ein nicht vom Menschen verursachter Klimawandel völlig andere Maßnahmen zur Vermeidung klimabedingter Schäden bedarf.

Aber schon Jesus, immerhin der Sohn Gottes, des Schöpfers dieser Welt, sagte: „Ein Prophet gilt nirgends weniger als in seinem Vaterland und in seinem Hause." Mt. 13,57, und Friedrich Schiller lässt Talbot in „Die Jungfrau von Orleans“ sagen: „Unsinn, du siegst und ich muss untergehn! Mit der Dummheit kämpfen Götter selbst vergebens.“

Wenn es nicht gelingen wird, durch Gerichtsentscheide die verhängnisvolle Klimalüge zu verbieten, wird es der Weltwirtschaft wie Talbot ergehen, denn selbst die öffentliche - rechtlichen Rundfunk- und Fernsehanstalten kommen ihrem Auftrag nicht nach.

Debatte im Bundestag - Schulze wirbt für Klimapaket.

Datum: 25.10.2019 11:42 Uhr

Der Bundestag hat in Berlin unter falschen Behauptungen mit den Beratungen der Gesetze zum Klimaschutz begonnen, die zu riesigen Fehlinvestitionen und einer falschen Ausrichtung der Energiepolitik führen werden.

Bundesumweltministerin Svenja Schulze (SPD) sagte, sie verstehe junge Menschen, die weiter auf den Straßen protestierten, und ihre Angst vor der Erderhitzung. Sie könne aber auch die Menschen verstehen, die sich existenzielle Sorgen machten über all die Veränderungen und um ihren Arbeitsplatz und den schnellen Wandel.

Diese ganze, zum Teil emotionsgeladenen aber von Fachkenntnis ungetrübte Debatte könnte man sich ebenso wie die Verunsicherung der Bevölkerung ersparen, wenn man die Bevölkerung nicht mit Fake News verunsichern, sondern über die gesicherten Fakten seriöser Wissenschaftler informieren würde.

Unter derÜberschrift: Schülerin, Klimaschützerin, globale Ikone:

Das ist Greta Thunberg: Swyrl.tv

wird der Leser informiert, dass Greta Thunberg väterlicherseits weitläufig mit Svante August Arrhenius verwandt sei, der 1903 als erster Schwede den Nobelpreis gewann. Unglaublich, aber wahr: Der Urahn der Klimaschützerin forschte tatsächlich über Treibhausgase und war der erste Wissenschaftler, der vorhersagte, dass der CO2 – Ausstoß der Menschheit zu globaler Erwärmung führen werde. (Hulton Archive / Getty Images) und damit begann die verhängnisvolle Entwicklung mit der wir es heute zu tun haben:

Die Theorie von Arrhenius wurde nur eine kurze Zeit, nämlich zwischen 1896 und Anfang des 20. Jh. ernsthaft diskutiert und 1909 durch den amerikanischen Physiker Robert W. Wood widerlegt. Die Theorie wurde erst Jahrzehnte später wieder neu aufgegriffen, um sie als Argument für den Bau von Atomreaktoren und gegen die Reaktorgegner zu verwenden. Fest steht ferner: Ein Zusammenhang zwischen einer Verdopplung im CO2 - Gehalt der Erdatmosphäre, gefolgt von globalen Temperaturveränderungen von einigen Grad ist ein rein mathematisches Konstrukt, für das es in der Realität keine Bestätigung gibt und auch nicht geben kann. Der Grund ist, dass Mathematiker grundsätzlich rechnen: „Wenn“ > „Dann“. Durch entsprechende Vorgaben, lässt sich auf jedes beliebige Ergebnis hinrechnen. Deshalb wird von der seriösen Wissenschaft stets ein Abgleich der mathematischen Ergebnisse mit der Realität gefordert.

Die 1896 von dem schwedischen Physiker Svante Arrhenius aufgestellte „Treibhaus-Theorie“ wurde bereits 1909 von dem amerikanischen Physiker Robert W. Wood widerlegt. Es gibt keinen „Treibhaus-Effekt“ in der Erdatmosphäre! Noch 1959 konnte man im „FRANCKE Lexikon der Physik“ nachlesen: „CO2 als Klimagas ist bedeutungslos“. Erst in den 60ger Jahren des vorigen Jahrhunderts wurde, wie bereits erwähnt, plötzlich CO2 als Argument gegen die Atomkraftgegner in dem luftverschmutzten Ruhrgebiet zum Klimagas proklamiert. Diese Luftverschnuzung wurde aber nicht durch CO2 sondern die Schadstoffaustoßungen der Industrie und dem steigenden Verbrennen von fossilen Energien verursacht. Hier laufen also zwei völlig voneinander unabhängige Prozesse ab. Unstrittig erhöht sich die Temperatur der Erdatmosphäre und unstrittig ist, dass der CO2 – Gehalt der Atmosphäre umso stärker ansteigt, je mehr fossile Energien verbrannt werden. Schließlich optimiert die Bundesregierung auch nicht die Biotope für Störche, um den Geburtenrückgang zu beheben. Es gilt also Zusammenhänge zu erkennen und nicht willkürlich Behauptungen unter das Volk zu bringen. Als dann der „saure Regen“ zu weiteren Umweltschäden führte, wurden erste Gegenmaßnahmen ergriffen aber CO2 – weiterhin in Verruf gebracht. Für Medien eine gute Einnahmequelle durch verbreiten von Ängsten und von Politikern, um von den Problemen mit den Atomkraftwerken abzulenken. So wurden wissenschaftliche Erkenntnisse, die die Volksverdummung gestört hätten nicht veröffentlicht und die Forschungsgelder nur an Einrichtungen vergeben, die weitgehend den gewünschten Mainstream unterstützten. Statt der angeblich anthropogen verursachten Klimaerwärmung handelte es sich in Wirklichkeit um eine mediogene und politogene Fehlinformation.

Entsprechend erarbeitet das Potsdamer-Institut für Klimaforschung, das unsere Bundeskanzlerin über die angebliche Klimaerwärmung durch CO2 berät, die gewünschten Ergebnisse und ignoriert Naturgesetze, wie den 2. Hauptsatz der Thermodynamik und ignoriert gesicherte Fakten. Mit Simulationsberechnungen, bei denen man willkürlich Werte einsetzen kann, um das gewünschte Ergebnis zu erhalten, werden gesicherte wissenschaftliche Erkenntnisse ignoriert und durch das Peer reviewing Verfahren werden unerwünschte Erkenntnisse unterdrück bzw. totgeschwiegen und in der Öffentlichkeit der Eindruck erweckt, dass die Berichte der Medien und die Argumente der Politiker dem aktuellen wissenschaftlichen Stand entsprechen. So schreibt Stefan Rahmstorf unter anderem: „ Erst seit den 50ger Jahren des vorigen Jahrhunderts wird die Gefahr einer anthropogenen (also vom Menschen verursachten) Erwärmung ernst genommen. Im Rahmen des internationalen geophysikalischen Jahres (IGY) 1957/58 gelang der Nachweis, dass die CO2 – Konzentration der Atmosphäre tatsächlich ansteigt. Die ersten Simulationsrechnungen mit einem Atmosphärenmodell in den 60ger Jahren ergaben einen Temperaturanstieg von 2 Grad Celsius für eine Verdoppelung der CO2 – Konzentration. In den 70ger Jahren warnte mit der National Academy of Sciences der USA erstmals eine Wissenschaftsorganisation vor der globalen Erwärmung; die Wirkung einer CO2 - Verdoppelung wurde auf 1,5 - 4,5 Grad Celsius abgeschätzt. Diese Unsicherheitsspanne gilt unverändert bis heute.“ Ende des Zitates.

Eine derartige Behauptung ist nicht das Papier wert, auf der sie geschrieben steht. Statistisch ist das eine „No go!“ Aussage. Aber die anthropogene Klimaerwärmung ist politisch gewollt und dann wird das auch durchgezogen, obwohl z.B. bereits 2001 von drei deutschen Behörden, nämlich der Bundesanstalt für Geowissenschaften und Rohstoffe in Hannover (eine nachgeordnete Behörde des Bundeswirtschaftsministeriums), dem Institut für Geowissenschaftliche Gemeinschaftsaufgaben und dem Niedersächsischen Landesamt für Bodenforschung, die Erkenntnisse ihrer wissenschaftlichen Mitarbeiter durch die Autoren Ulrich Berner und Hansjörg Streif in Buchform auf 238 Seiten dargelegt und veröffentlicht wurden. Die Wissenschaftler dieser Behörden kamen im Hinblick auf den Zusammenhang zwischen der Zunahme des Treibhausgases CO2 und der Erderwärmung in den letzten 150 Jahre zu der Schlussfolgerung, dass „die beobachteten Temperaturanstiege bzw. -abnahmen ohne Bezug zu CO2 erfolgten.“ Das Buch erschien 2001 im Stuttgarter Fachverlag E. Schweizerbart unter dem Titel „Klimafakten. Der Rückblick - Ein Schlüssel für die Zukunft“.

Der Verlag schreibt zu dem Buch: „Wenige Themen nehmen heute in Politik und Medien ähnlich breiten Raum ein wie Klima - Klimaänderungen - Klimakatastrophen. Meist geht es dabei um mögliche Auswirkungen menschlicher Eingriffe in das Klimasystem. Oft unterschätzt man allerdings das Ausmaß und die Dynamik natürlicher Klimaschwankungen. Rückblickend auf die Erdgeschichte legen Geowissenschaftler im vorliegenden Sachbuch ihr umfangreiches Wissen über das Klima vergangener Zeiten vor. Aus den hinterlassenen Gesteinen, dem Grundwasser und dem Eis großer Gletscher gewinnen sie eine Fülle von Informationen, wie z.B. über Wassertemperaturen ehemaliger Ozeane, die Luftfeuchtigkeit bzw. Trockenheit untergegangener Kontinente oder die Gaszusammensetzung einer früheren Atmosphäre. Dieser Rückblick ist gleichzeitig auch ein Schlüssel für die Zukunft, weil er eine Bewertung der verschiedenen im Klimasystem wirksamen Faktoren erlaubt. Hervorzuheben ist dabei, dass nicht das oft zitierte Kohlendioxid bestimmender Faktor des Klimageschehens ist. Vielmehr treibt die Sonne wie ein Motor die klimawirksamen Prozesse in der Atmosphäre, den Ozeanen und in der Biosphäre an. Zahlreiche Belege aus der Natur sprechen für eine wahre "Achterbahnfahrt" des Klimas durch die Erdgeschichte. Wer mehr zum Thema Klima erfahren möchte, findet in diesem Buch umfassende, auch dem Laien verständliche Informationen. In anregender Form sprechen die Autoren offene Fragen an und vermitteln neue Denkanstöße. Erstmalig wird hier aus der Sicht der Geowissenschaft Stellung zur aktuellen Klimadiskussion bezogen. Mit dem hier vorgelegten, erheblich erweiterten Hintergrundwissen sind viele bisher getroffene Aussagen zum Thema Mensch und Klima höchst kritisch zu bewerten.“ Ende des Zitates

Am 31. August 2017 erschien im Fachblatt Review of Policy Research eine bemerkenswerte Arbeit, in der sich Hannah Rachel Hughes von der Cardiff University und Matthew Paterson von der University of Manchester mit der Zusammensetzung der Autoren der IPCC-Arbeitsgruppe III beschäftigen. Das Resultat der Analyse ist erschreckend: Offenbar kontrolliert eine kleine Gruppe von Autoren und Institutionen den Inhalt der Berichte. Wie robust sind die Klima-Zusammenfassungen also wirklich, wenn eine kleine Clique das Zepter fest in der Hand hält? Hughes und Paterson sehen hier die inhaltliche Ausgewogenheit in Gefahr und stellen die Glaubwürdigkeit der Organisation in Frage. Sie befürchten eine Politisierung der Klimawissenschaften, wobei die nüchterne und ergebnisoffene Darstellung auf der Strecke bleibt.

Der emeritierte Physikprofessor, man beachte das Wort „emeritiert“, (offensichlich fürchtete er in seinem Berufsleben weitreichende Konsequenzen) Harold Lewis tritt aus der Amerikanischen Physikalischen Gesellschaft aus und bezeichnet die menschlich verursachte Erderwärmung als den „größten und erfolgreichsten pseudowissenschaftlichen Betrug, den ich während meines langen Lebens gesehen habe.“ In seinem Rücktrittsschreiben gewährt er tiefe Einblicke in die Machenschaften einer durch eine „Flut aus Geldern …korrumpierten“ Bagage pseudowissenschaftlicher Berufsverbrecher, deren einziges Interesse die Jagd nach Forschungsgeldern und Karrieremöglichkeiten ist.

Der Treibhauseffekt ist seit 1909 als physikalischer Unsinn entlarvt. Sämtliches Geschwätz vom Treibhaus ist als Unfug aufgeflogen. Der Physiker Robert W. Wood hat es widerlegt, weil auch die Physik nichts anderes zulässt. Die Physik kann man nicht austricksen und die sagt, der Treibhauseffekt hat noch nie existiert und es gibt nur eine Physik.

Die Physiker Gerlich/Tscheuschner haben übrigens ebenfalls die Erkenntnisse von Prof. Wood und das "Woodsche Experiment" aus dunkler Vergangenheit wieder ans Licht gebracht und bestätigt, dass CO2 kein Treibhausgas ist und die Behauptung der Medien und der Politiker gegen den 2. Hauptsatz des Thermodynamik Gesetzes verstoßen.

Deshalb ist es wichtig noch einmal festzustellen, das IPCC (Intergovernmental Panel on Climate Change, auch Weltklimarat genannt), ist eine politische Institution, die Berichte zusammenträgt und in den sog. „IPCC Assessment Reports“ veröffentlicht. Es betreibt selbst keine Wissenschaft, sondern hat die Aufgabe, die Ergebnisse der Forschung in den unterschiedlichsten Fachbereichen zusammenzutragen, insbesondere auf dem Gebiet der Klimatologie. Das hat aber nichts mit einer wissenschaftlichen Einrichtung zu tun. Sogenannte Review Editors kontrollieren, ob die Berichte linienkonform sind und auch bleiben. Diese Berichte bilden also die Basis der politischen und „wissenschaftlichen“ Diskussionen über die globale Erwärmung, da andere gesicherte Erkenntnisse totgeschwiegen werden. Wenn also über die Erderwärmung durch CO2 diskutiert wird, ist es zwingend zu erwähnen, ob man gekaufte Behauptungen oder die Erkenntnisse seriöser Wissenschaftler zur Argumentation benutzt.

Dazu ist zu sagen, dass man vor etwa 150 Jahren, als man mit der Aufzeichnung der CO2 Konzentrationen in der Atmosphäre begann, bis heute, der damalige Ausgangswert von 280 ppm auf 419 ppm im Mai 2019 angestiegen ist. Das heißt, in 139 Jahren stieg die CO2 Konzentration um 139 ppm. Um die Größe und Aussagekraft dieser Zahlen zu veranschaulichen, möchte ich darauf hinweisen, was das in Zahlen ausgedrückt bedeutet:

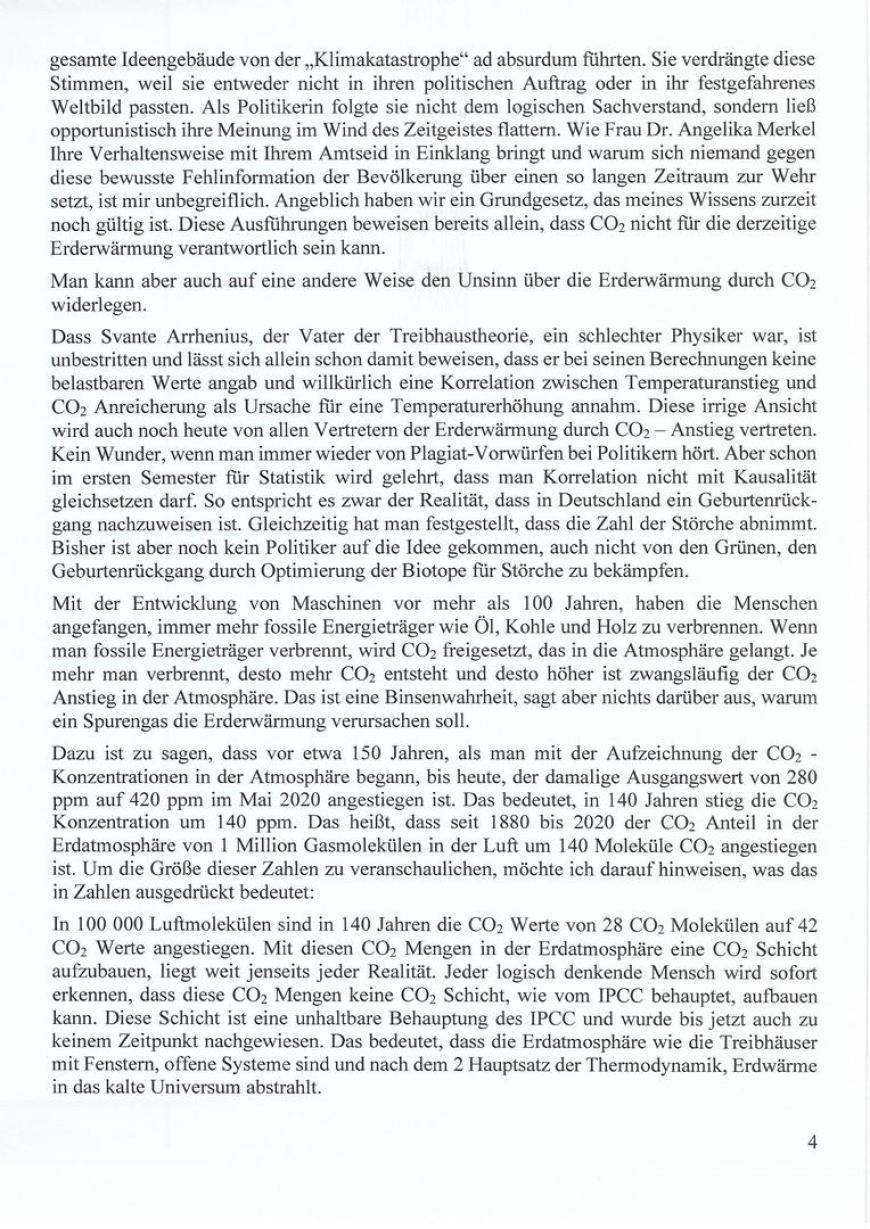

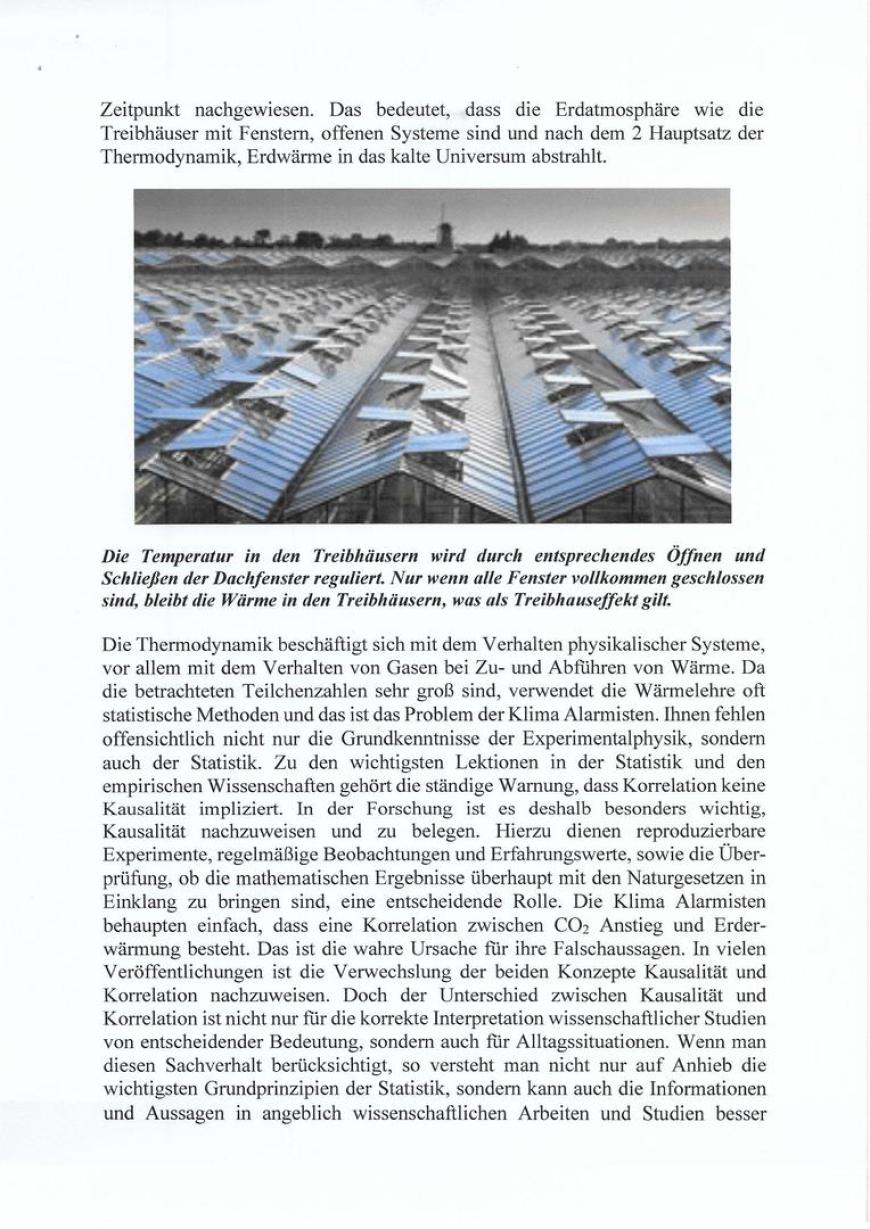

In 100 000 Luftmolekülen sind in 139 Jahren die CO2 Werte von 28 CO2 Molekülen auf 41,9 CO2 Werte angestiegen. Mit diesen CO2 Mengen eine CO2 Schicht aufzubauen, die wie bei den Treibhäusern die Wärme unter einer Glashaube zurückhält, liegt weit jenseits jeder Realität. Wenn es aber in derartigen Treibhäusern ebenso wie in einem in der Sonne geparktem Auto zu heiß wird, braucht man nur die Fenster zu öffnen, um die Temperatur der Umgebungstemperatur wieder anzugleichen. Logische Konsequenz: Ohne geschlossene CO2 Schicht in der Erdatmosphäre auch keine Klimaerwärmung. Siehe Zweiter Hauptsatz der Wärmelehre.

Zusammenfassung: Jeder logisch denkende Mensch wird sofort erkennen, dass diese CO2 Mengen keine entsprechende CO2 Schicht, aufbauen kann. Diese Schicht ist eine unhaltbare Behauptung des IPCC und wurde bis jetzt auch zu keinem Zeitpunkt nachgewiesen. Das bedeutet, dass die Erdatmosphäre wie die Treibhäuser mit Fenstern, offene Systeme sind und nach dem 2. Hauptsatz der Thermodynamik, Erdwärme in das kalte Universum abstrahlt, denn der zweite Hauptsatz der Thermodynamik, auch 2. Hauptsatz der Wärmelehre genannt, macht eine Aussage über die Richtung der Energieübertragung bei Vorgängen in Natur und Technik: Wärme geht niemals von selbst von einem Körper niederer Temperatur zu einem Körper höherer Temperatur über. Wenn man das den Schülern im Unterricht erklären würde, brauchten sie sich nicht zum eigenen Schaden als Helfeshelfer interessierter Kreise missbrauchen lassen. Erschreckend ist bei der ganzen Sachlage, dass offensichtlich auf der ganzen Welt kein Physiklehrer es wagt, den Schülern zu erklären, warum aus physikalischen Gründen 42 CO2 Moleküle unter 100 000 Luftmolekülen keinen Treibhauseffekt erzielen können. Wir haben es folglich mit einem „Friday for Stupids“ zu tun.

Die Riokonferenz zur Nachhaltigkeit von 1992 bereitete den internationalen politischen Boden für den ganzen Unsinn auf Grund wirtschaftlicher Interessen vor, unter aktiver Beteiligung der jetzigen Bundeskanzlerin, der promovierten Physikerin Frau Dr. Merkel, und schon wurde alle Kritik unterdrückt. Ihre Energiegesetzgebung wurde vor allem mit dem „Klimaschutz" begründet und dem Ziel den Atomkraftgegnern den Wind aus den Segeln zu nehmen. Schließlich sollte die konventionelle Energieversorgung nachhaltig zu Gunsten der Atomenergie abgebaut werden. Naturgesetze hin, physikalisches Grundwissen her und so wurde der Treibhauseffekt politisch hoffähig und das wissenschaftliche Establishment schwieg dienstbeflissen. Nach der Nuklearkatastrophe am 11. März 2011 im japanischen Kernkraftwerk Fukushima kam unsere Bundeskanzlerin innerhalb von 3 Tagen zu völlig neuen Erkenntnissen und beschloss spontan den Ausstieg aus der Kernenergie, obwohl erst kurz zuvor die Laufzeit der Kernkraftwerke verlängert worden war. Anstatt einen sinnvollen und geordneten Rückzug aus der Kernkraft, wurde völlig überstürzt die alternative Energiegewinnung angeordnet. Um die dadurch entstehenden Kosten einigermaßen abzudecken, war es notwendig und wichtig die Angst durch das angebliche Treibhausgas CO2 wieder hochzufahren und die öffentlich - rechtlichen Rundfunk- und Fernsehanstalten sorgten für ein entsprechendes Klimabewusstsein in der Bevölkerung, siehe Bericht über Demonstration in Aachen. Hier mussten wieder Polizisten und Polizistinnen, viele davon selber Eltern, ihren Kopf hinhalten, weil ihre Kinder in der Schule nicht gelernt hatten, dass CO2 nicht für die Klimaerwärmung verantwortlich ist.

Die Theorien der Vertreter der Theoretischen Physik über unser Weltbild beruhen auf willkürlichen Annahmen, der Verliebtheit von Mathematikern in die Eleganz und Symmetrie ihrer Formeln, der Fehlinterpretation von Experimenten und dem Ignorieren von Fakten und Naturgesetzen. So postulierte der Mathematiker und Theoretische Physiker Henri Poincaré: „Das Ästhetische ist mehr als das Logische die dominierende Komponente in der mathematischen Kreativität." Paul Dirac, britischer Physiker, Nobelpreisträger und Mitbegründer der Quantenphysik, wurde noch deutlicher: „Es ist wichtiger, dass eine Gleichung schön ist, als dass sie mit dem Experiment übereinstimmt." (12. Heft aus der Reihe: Gegenworte, Hefte für den Disput über Wissen - Martin Aigner: „Die pure Eleganz der Mathematik“).

Das kommt einem Offenbarungseid gleich und zeigt, wie gefährlich Mathematik in falschen Händen sein kann. Willkürlich werden Anfangszustände postuliert und Tatsachen verschwiegen, um Vorhersagen behaupten zu können, die nichts mit der Realität zu tun haben.

Die Ergebnisse der Eiskernbohrungen in der Antarktis und auf Grönland bezeugen, dass Temperaturerhöhungen im Durchschnitt 800 Jahre früher auftraten als der Anstieg der CO2-Konzentrationen in der Luft. (Dr. Davis Evans, Klimawissenschaftler, im „The Australian“ 18. Juli 2008). Der Grund für diese Zeitverzögerung ist die Tatsache, dass sich das Wasser der Weltmeere entsprechend später erwärmt als die Erdatmosphäre. Wenn sich das Wasser schließlich ebenfalls erwärmt, gast es das in ihm gelöste CO2 aus und die CO2 Werte in der Atmosphäre steigen auch nach einem erneuten Absinken der Temperaturen der Erdatmosphäre so lange weiter an, bis sich auch das Wasser der Weltmeere wieder abkühlt und CO2 aus der Atmosphäre wieder im Wasser gelöst wird und die CO2 Werte der Atmosphäre sinken wieder. Dieser Sachverhalt zeigt, dass der CO2-Anstieg als Folge einer Erderwärmung anzusehen ist und nicht umgekehrt. Diese Fakten besagen eigentlich alles über Ursache und Wirkung. Fakten sind aus wissenschaftlicher Sicht aber das Todesurteil selbst der schönsten Theorie. Hinzu kommt, dass diese Fakten unumstritten sind, wie Dr. Evans ausdrücklich versichert.

Wenn die Physiklehrer nicht schweigen, sondern die Schüler seriös unterrichten würden,

Hätten weder Medien noch Politiker eine Chance, dass sie die Bevölkerung weiterhin falsch informieren, um durch eine CO2 – Besteuerung den Bürgern in die Tasche zu greifen, sowie Banken und anderen Profiteuren die Lizenz zum Gelddrucken zu ermöglichen.

CO2 ist lebensnotwendig und nicht für die Erderwärmung verantwortlich.

Dr. Herwig Horst Schmidt

Ende der Abhandlung

************************************************************************************************************

Text zur Homöopathie

Text zur Klimalüge: CO2 ist nicht für die Klimaerwärmung verantwortlich.

Die Klimalüge. Inuit belehren westliche Eliten.

Die amerikanische Webseite »Natural News« berichtete, dass die Inuit (zurzeit die Sammelbezeichnung für die Völker Eskimos, Inupiat, Kalaalit, Yupik) sich im letzten Jahr an die NASA gewandt haben. Sie teilten der US-amerikanischen Raumfahrtbehörde mit, dass der Himmel sich geändert habe, viele Dinge sich gewandelt haben und sie vermuten, dass die Erdachse sich ein wenig verschoben haben könnte. Ihre Warnung verhallte bei der NASA ungehört.

Alle Inuitvölker im Polarkreis machen dieselben Beobachtungen. Sie glauben nicht, dass vom Menschen in die Atmosphäre entlassenes CO2 diese Veränderungen hervorrufen kann. Es geht nämlich nicht nur um Klimaveränderungen. Der Lauf der Sonne, ihre Aufgangspunkte und Untergangspunkte, die Stellung der Sterne und die Winde haben sich leicht, aber bemerkbar verschoben. Die Sonne geht im Winter früher auf und später unter. Früher habe es nur eine Stunde Licht im Mittwinter gegeben, heute sind es zwei. Die Tage werden länger und die Sonneneinstrahlung ist wesentlich höher. Sie beobachten die zunehmenden, schmelzenden Gletscher, die Verbrennungen an den Körpern der Seehunde und die Beschädigungen ihrer Haut. Die Ältesten behaupten, dass die Sonne seit einiger Zeit nicht mehr dort aufgeht, wo sie früher einmal aufging und die Tage wärmer geworden sind und spürbar länger dauern als früher. So ging früher nach der langen Winterpolarnacht die Sonne pünktlich am 13. Januar zum ersten Mal wieder über der grönländischen Stadt Ilulissat auf. Seit 2011 ereignet sich dieser erste Sonnenaufgang im neuen Jahr aber am 11. Januar.

Auch die Sterne und der Mond haben ihre Position am Himmel leicht verändert. Dies alles beeinflusst die Temperaturen, da sind sich die Ältesten der Inuit sicher. Sie haben von ihren Vorfahren wiederum die äußerst feine und aufmerksame Beobachtung der Natur, der Winde, des Himmels, der Sonnenauf- und Untergangspunkte gelernt, weil das für das Überleben dort in der gnadenlosen Eiswüste unabdingbar ist. Die Inuit beobachten all diese feinen Zeichen viel genauer und aufmerksamer und sind unbeeindruckt und unabhängig von einseitigen Medienberichten.

Erdachsverschiebung- die Beobachtung der Inuit - YouTube

https://www.youtube.com/watch?v=37RT2u9sA_Q

12.07.2011 - Hochgeladen von conrebbi

Sowohl die Beobachtungen der Inuit vom Jahreswechsel 2010/2011, als auch die Meldung der ...

Richtlinien für seriösen Journalismus:

Die Informationen müssen durch Darstellung der wesentlichen Materialien der eigenen Meinungsbildung dienen. Sie dürfen dabei nicht durch Weglassen wichtiger Tatsachen, durch Verfälschung oder durch Suggestivmethoden die persönliche Entscheidung zu bestimmen versuchen.

Es ist darauf zu achten, dass gegensätzliche Standpunkte möglichst gleichwertig behandelt werden. Werturteile über Personen und Tatbestände müssen als persönliche oder redaktionelle Meinung zu erkennen sein. Sie haben dem Gebot journalistischer Fairness zu entsprechen.

Die Medien und Politiker lügen nicht, sie manipulieren nur die Menschen und korrigieren die Fakten.

Die Irrlehre von der Klimaerwärmung durch CO2.

So wie die Inquisition wider besseres Wissen darauf bestand, dass sich die Sonne um die Erde zu drehen hat, weil die Kirche nicht zu kontrollierende Auswirkungen für den Glauben fürchtete, so beharrt unsere Regierung ebenfalls wider besseren Wissens im Interesse bestimmter Wirtschaftszweige darauf, dass sich das Klima auf unserem Planeten durch steigenden CO2 – Werte in der Atmosphäre als Folge vermehrter Verbrennung fossiler Energiequellen durch den Menschen erwärmt. Die Vorgehensweise der Bundesregierung gegen die Skeptiker, wie man heute die Ketzer früherer Zeiten nennt, ist zwar nicht so rustikal, dafür aber wesentlich effektiver mit verhängnisvollen Auswirkungen für unangepasste Wissenschaftler, einer breiten Öffentlichkeit und den ganzen Planeten.

Bereits vor 2400 Jahren hatte der griechische Astronom und Mathematiker Aristarchos von Samos (310-230 v.Chr.) darauf hingewiesen, dass die jahreszeitlichen Klimaänderungen auf unserem Planeten allein durch die Neigung der Erdachse auf ihrer Bahn um die Sonne und der dadurch bedingten unterschiedlich starken Sonneneinstrahlung sowie die Lage der Bahnebene der Erde zur Sonne bei deren Umrundung hervorgerufen werden. Bis heute wurde die folgenschwere Erkenntnis dieses Genies immer noch nicht ganz verstanden, obwohl inzwischen unstrittig ist, dass seine Argumentation, die Jahreszeiten seien nur durch die Neigung der Erdachse zur Sonne zu erklären, allgemein anerkannt wird. Aber im Interesse der Politik und bestimmter Lobbyisten hat unser Planet nicht zu wackeln oder die Ebene der Umlaufbahn um die Sonne zu verändern. Basta! Das wäre ja auch noch schöner, wenn die Natur machen könnte was sie will. Wie spottete dereinst Albert Einstein? „Wenn die Fakten nicht zur Theorie passen, ändere die Fakten .....!“

Seit mehr als 100 Jahren gehen einige Forscher davon aus, dass das bei der Verbrennung fossiler Brennstoffe freigesetzt CO2, wie auch andere chemische Verbindungen z. B. Methan und Lachgas (Distickstoffmonoxid), zur Klimaerwärmung beitragen kann. Allerdings besitzen diese chemischen Verbindungen ein deutlich höheres Erwärmungspotential als CO2.

Übersicht über wichtige anthropogene Treibhausgase

CO2 279 ppm 391 ppm

CH4 730 ppm 1803 ppm

N2O 270 ppm 324 ppm

Vorindustrielle Werte Werte von 2011

Der Energiehaushalt der Erde besteht aus einer feinen Bilanz kurzwelliger Sonnenstrahlung, die von der Erdoberfläche absorbiert und langwelliger Infrarotstrahlung, die wieder zum Weltall reflektiert wird. Der Treibhauseffekt soll darauf beruhen, dass ein großer Teil dieser Infrarotstrahlung von Molekülen in der Atmosphäre wie etwa CO2 oder Wasserdampf aufgenommen und wieder zur Erde reflektiert wird. Dabei wird verschwiegen, dass Gase die Eigenschaft haben, ausschließlich elektromagnetische Wellen ganz bestimmter Wellenlängen zu „absorbieren“ und wieder abzustrahlen. Eine Eigenschaft, die man bei der Spektralanalyse zur Identifizierung der Gase nutzt, denn jedes Gas absorbiert andere Wellenlängen oder Wellenlängenbereiche, die charakteristisch für dieses Gas sind. Wenn man die Licht- oder Wärmestrahlung angeben will, die absorbiert wird, nennt man die betroffene Wellenlänge bzw. den Weitenlängenbereiche. Diese sind unabhängig von der Temperatur des Gases. CO2 absorbiert Wärmestrahlung in drei Wellenlängenbereichen. Die Absorptionslinien des CO2 entsprechen den Temperaturen +759°C, +369°C und -80° C, also einem winzigen Ausschnitt des gesamten abgestrahlten Spektrums. Aber selbst diese Abstrahlung wird nur zum Teil auf die Erde reflektiert, da die Moleküle nach allen Seiten abstrahlen.

Im November 1957 hatte der Chemiker Keeling begonnen, mit einem neuen Analyse-Gerät den CO2-Gehalt der Luft kontinuierlich zu messen. Seine Messungen, aus denen sich die berühmte Keeling-Kurve ergab, legten den Grundstein für den Nachweis, dass die CO2-Konzentration in der Luft kontinuierlich ansteigt. Zur gleichen Zeit glaubte man einen Temperaturanstieg der Erdatmosphäre zu beobachten und so schloss man messerscharf, dass dies auf die von Menschen verursachten Emissionen von Treibhausgasen zurückzuführen ist, ohne zu überprüpfen, ob nicht eine zufällige Koinzidenz besteht. Wenn sich z. B. jemand eine Zigarette anzündet und gleicheitig ein Unwetter hereinbricht, so muss diesbezüglich kein Zusammenhang bestehen.

1958 lag der CO2-Gehalt der Luft noch bei 315 ppm. Keeling stellte bei seinen Messungen typische jahreszeitliche Schwankungen fest, die durch die Vegetation bedingt sind. Da es auf der nördlichen Halbkugel größere Landmassen und deshalb mehr Pflanzen gibt, wird im nördlichen Frühjahr mehr CO2 aufgenommen als im nördlichen Herbst, woraus sich das Zickzackmuster der „Atmung“ ergibt. 1960 veröffentlichte Keeling seine ersten Ergebnisse und wies erstmals auf eine leichte, aber kontinuierliche Zunahme der CO2-Konzentration als Folge der gesteigerten Verbrennung fossiler Brennstoffe durch die Industrie hin. Ohne irgendeinen Beweis zu liefern, behaupteten daraufhin interessierte Kreise, dass die Erderwärmung durch einen auf der Zunahme der CO2 Moleküle beruhenden Treibhauseffekt erfolge. Diese Argumentation ist umso erstaunlicher, als in den letzen 150 Jahren die Zahl der CO2 Moleküle von 238 um 122 Moleküle auf 400 unter einer Million anderer Luftmoleküle, einen Anstieg der Temperatur auf unserem Planeten um 1,5 bis 2 Grad bewirkt haben soll. Für die Klimalobbyisten galt bereits der gleichzeitige Anstieg von CO2 Molekülen und der Temperatur als Beweis, dass CO2 für die Klimaerwärmung verantwortlich ist. Ob ein tatsächlicher Zusammenhang zwischen den gemessenen Werten besteht, wurde nicht überprüft bzw. Kritiker einer derartigen Beweisführung mundtot gemacht. Schließlich galt es die Kritiker der Kernenergie zum Schweigen zu bringen.

Zum scheinbaren Beweis bediente man sich zusätlich käuflicher Wissenschaftler, die dank ihrer Abstraktionen, völlig unauffällig für den Laien, von der Wirklichkeit abheben und über Computermodelle, die ja das Ergebnis willkürlicher Vorgaben für die Mathematiker sind, die breite Öffentlichkeit täuschen. Man kann also je nach Vorgaben, auf jedes gewünschte Ergebnis hinrechnen.

Margret Thatcher, von Mai 1979 bis November 1990 Premierministerin des Vereinigten Königreichs, nutzte diese Vorgehesweise, um die Atomkraft durchzusetzen und die Bergbaugewerkschaften in Großbritannien zu zerschlagen. Ferner erklärte sie CO2 zum Klimagift, obwohl es viele andere Gründe gegeben hätte, Kohlekraftwerke abzulehnen. Nitrose Gase, Schwefeloxide, Stickstoffoxide, CO2 und Rußpartikel (Smog) waren damals bereits als Ursache für den sauren Regen, auftretende Atemnot sowie „Schwarze Wäsche“ und das Land Nordrheinwestfalen als „das Land ohne Sonne“ bekannt. Zwischenzeitlich wurden all diese Emissionen durch geeignete Filtertechniken, sowie andere chemische und physikalische Maßnahmen stark reduziert, aber CO2 als Klimakiller ließ sich leicht und erfolgreich vermarkten.

Der Philosoph Professor Dr. Klaus Fischer von der Universität Trierstellte in: „Die politische Konstruktion der Universitätskrise - Siebzehn Thesen zu einer merkwürdigen Diskussion.“ (November 1997, 51. Jahrgang, Heft 584, pp 1003-1011) Folgendes fest.

Seine 7. These lautet: „Das deutsche System der Forschungsförderung ist nicht auf das Erkennen des Außergewöhnlichen, sondern auf die Belohnung des konsensfähigen Mittelmaßes angelegt.“

Die These 15 lautet: „Die Zwänge des „peer- reviewing – Systems“ führen zu einer Konvergenz der Meinungen, die nicht durch Fakten und Überzeugungen, sondern von der Notwendigkeit geleitet wird, Verbündete im Kampf um Forschungsmittel zu suchen.“

Die These 17 spricht die Konsequenzen dieses Fehlverhaltens an: „Unsere Politiker werden es womöglich schaffen, die deutschen Universitäten tatsächlich so zu schädigen, dass diese These von ihrer „Verrottetheit“ nicht nur eine populistische Parole ist: Durch weitere Überlastung mit neuen Aufgaben, durch den Zwang der Verlagerung mit neuen Aufgaben, durch den Zwang der Verlagerung knapper Ressourcen von Forschung und Lehre auf Analyse des eigenen Innenlebens, durch weitere Politisierung der Wirtschaft, durch Mobilisierung von Ressentiments gegen Außenseiter, Innovateure und andere unabhängige Geister, die sich nicht in Zitations- und Begutachtungsnetzwerke einfügen wollen.“ Ende der Zitate

Im gleichen Jahr (am 11. Dezember 1997) wurde in Kyoto ein Abkommen zur Ausgestaltung der Klimarahmenkonvention der vereinten Nationen getroffen, in welchem Zielwerte für den Ausstoß von Treibhausgasen in den Industrieländern vereinbart wurden, da man diese Gase und insbesondere CO2 für die hauptsächliche Ursache der globalen Erderwärmung hielt. Bis Anfang 2011 hatten 191 Staaten sowie die Europäische Union das Kyotoprotokoll ratifiziet.

Bereits am 25. Oktober 1999 stellte der damalige Bundeskanzler Gerhard Schröder in seiner Rede zur Eröfnung der 5. Vertragsstaaten- oder Folgekonferenz der Klimarahmenkonventionen unter anderem fest: „Umweltschutz ist aber kein Luxus. Nur wenn wir die natürlichen Lebensgrundlagen der Menschheit dauerhaft schützen,kann es eine tragfähige und dauerhafte wirtschaftliche Entwicklung geben. Das gilt für das einelne Land genauso wie weltweit. Alles andere wäre ein gefährlicher Irrtum. In keinem Bereich tritt dies deutlicher zutage als bei der Erwärmung der Erdatmosphäre und dem Treibhauseffekt. Kein anderes Umweltproblem ist derart bedrohlich für die gesamte Menschheit. Gerade deshalb müssen wir zu Beginn der 5. Vertragskonferenz in Bonn die Frage stellen: „Wo stehen wir heute im Klimaschutz?“ Ende des Zitates.

Es nützte auch nichts, dass am 13. März 2001 der US-Präsident George W. Bush erklärt hatte: „I oppose the Kyoto Protocol!“, da er nicht an die CO2 – Lüge glaubte. Damit löste er zwar kurzzeitig einigen Wirbel aus, aber interessierten Kreisen gelang es, insbesondere in der Bundesrepublik Deutschland, wieder schnell die Weltöffentlichkeit einzuschläfern. Damals wies Herr Bush auch zu Recht darauf hin, dass CO2 nach dem Luftreinhaltegesetz nicht zu den Luftschadstoffen zählt. Ohne CO2 würden schließlich weder Pflanzen wachsen noch Tiere und Menschen leben. Die teils unsachliche Kritik des jetzigen US-Präsident Trump am Pariser-Klimaabkommen ist aber insofern hilfreich, als sie dazu geführt hat, dass diese Problematik noch einmal weltweit diskutiert wird.

Bereits 2001 wurden von drei deutschen Behörden, nämlich der Bundesanstalt für Geowissenschaften und Rohstoffe in Hannover (eine nachgeordnete Behörde des Bundeswirtschaftsministeriums), dem Institut für Geowissenschaftliche Gemeinschaftsaufgaben und dem Niedersächsischen Landesamt für Boden-forschung, die Erkenntnisse ihrer wissenschaftlichen Mitarbeiter durch die Autoren Ulrich Berner und Hansjörg Streif in Buchform auf 238 Seiten dargelegt und veröffentlicht. Die Wissenschaftler dieser Behörden kamen im Hinblick auf den Zusammenhang zwischen der Zunahme des Treibhausgases CO2 und der Erderwärmung in den letzten 150 Jahre zu der Schlußfolgerung, dass „die beobachteten Temperaturanstiege bzw. -abnahmen ohne Bezug zu CO2 erfolgten.“ Das Buch erschien 2001 im Stuttgarter Fachverlag E. Schweizerbart unter dem Titel „Klimafakten. Der Rückblick - Ein Schlüssel für die Zukunft“.

Der Verlag schreibt zu dem Buch: „Wenige Themen nehmen heute in Politik und Medien ähnlich breiten Raum ein wie Klima - Klimaänderungen - Klimakatastrophen. Meist geht es dabei um mögliche Auswirkungen menschlicher Eingriffe in das Klimasystem. Oft unterschätzt man allerdings das Ausmaß und die Dynamik natürlicher Klimaschwankungen. Rückblickend auf die Erdgeschichte legen Geowissenschaftler im vorliegenden Sachbuch ihr umfangreiches Wissen über das Klima vergangener Zeiten vor. Aus den hinterlassenen Gesteinen, dem Grundwasser und dem Eis großer Gletscher gewinnen sie eine Fülle von Informationen, wie z.B. über Wassertemperaturen ehemaliger Ozeane, die Luftfeuchtigkeit bzw. Trockenheit untergegangener Kontinente oder die Gaszusammensetzung einer früheren Atmosphäre. Dieser Rückblick ist gleichzeitig auch ein Schlüssel für die Zukunft, weil er eine Bewertung der verschiedenen im Klimasystem wirksamen Faktoren erlaubt. Hervorzuheben ist dabei, dass nicht das oft zitierte Kohlendioxid bestimmender Faktor des Klimageschehens ist. Vielmehr treibt die Sonne wie ein Motor die klimawirksamen Prozesse in der Atmosphäre, den Ozeanen und in der Biosphäre an. Zahlreiche Belege aus der Natur sprechen für eine wahre "Achterbahnfahrt" des Klimas durch die Erdgeschichte. Wer mehr zum Thema Klima erfahren möchte, findet in diesem Buch umfassende, auch dem Laien verständliche Informationen. In anregender Form sprechen die Autoren offene Fragen an und vermitteln neue Denkanstöße. Erstmalig wird hier aus der Sicht der Geowissenschaft Stellung zur aktuellen Klimadiskussion bezogen. Mit dem hier vorgelegten, erheblich erweiterten Hintergrundwissen sind viele bisher getroffene Aussagen zum Thema Mensch und Klima höchst kritisch zu bewerten.“

Auch beim 58. Nobel Laureate Treffen in Lindau vom 29.06. - 04.07.2008 wurde durch den Vortrag von Dr. David Evans auf Grund fundierter Forschungsergebnisse der Nachweis erbracht, dass CO2 – nicht für die derzeitige Klimaerwärmung verantwortlich ist, wie interessierte Kreise glaubhaft machen wollen.

In seinem Vortrag „No smoking hot spot“ führte Dr. David Evans damals aus, dass die Ergebnisse der Eiskernbohrungen in der Antarktis und auf Grönland bezeugen, dass Temperaturerhöhungen im Durchschnitt 800 Jahre früher auftraten als der Anstieg des CO2 - Niveaus. Der späte Anstieg der CO2 - Werte beruhe darauf, dass sich die Erdatmosphäre schneller erwärmt, als das Wasser in den Meeren. Wenn sich Wasser erwärmt, wird das im Wasser gelöste CO2 freigesetzt und an die Erdatmosphäre abgegeben. Wenn sich die Atmosphäre zu einem späteren Zeitpunkt wieder abkühlt, kühlt sich entsprechend später das Wasser der Meere wieder ab und CO2 löst sich wieder aus der Erdatmosphäre. Der CO2 - Wert in der Erdatmosphäre sinkt folglich auch. Das sagt eigentlich alles über Ursache und Wirkung!

Die Öffentlichkeit und unsere Politiker kennen offensichtlich nicht die maßgebenden Zusammenhänge und Fakten: Denn keiner der von Dr. Evans erwähnten Punkte ist umstritten. Selbst die Klimaalarmisten stimmen ihnen zu, bezweifeln aber ihre Bedeutung.

Eine offene Diskussion zu diesem Thema wurde in den letzten 18 Jahren zu keinem Zeitpunkt geführt, die Öffentlichkeit wurde gebetsmühlenhaft einseitig von allen Medien und Parteien einseitig informiert und mit Panikmache, statt Durchsetzung gesicherter seriöser und effektiver Maßnahmen, riesige Geldsummen „verbrannt“.

Unwillkürlich fragt man sich nach der Logik, die hinter einer derartigen Ablehnung steckt. Die Argumente der Klimaalarmisten, dass Berechnungen die Klimaerwärmung durch CO2 ergeben, sind keine Beweise, weil die Ergebnisse von den jeweiligen Vorgaben abhängen und wenig über die damaligen Umweltverhältnisse aussagen. Die unterschiedlichsten Wechselwirkungen waren und sind derart komplex, dass sie zu keinem Zeitpunkt erfasst und seriös dargestellt werden können. Sind die Vorgaben jedoch falsch, kann das Ergebnis nicht richtig sein. Die Bohrkerne zeigen zwar eindeutige Ergebnisse, sagen aber nichts über die Ursachen aus.

In der Eröffnungsrunde der 58. Nobel Laureate Treffen in Lindau vom 29.06. - 04.07. äußerte sich Porfessor Giaever (Nobelpreisträger 1973) wie folgt: „Die globale Erwärmung ist zu einer neuen Religion geworden. Alltäglich hören wir von der großen Anzahl von Wissenschaftlern, welche diese unterstützen. Aber nicht die Anzahl ist entscheidend, sondern diejenigen die Recht behalten.“ Ende des Zitates.

Auch die beiden Diplomphysiker der TU Braunschweig, Prof. Dr. G. Gerlich und Dr. R. D. Tscheuschner haben auf 114 Seiten den angeblichen atmosphärischen Treibhauseffekt eindeutig widerlegt, indem sie unter anderem auch nachweisen konnten, dass diese Theorie gegen den zweiten Hauptsatz der Thermodynamik verstößt, was aber von den Medien in Deutschland weitgehend totgeschwiegen wird. Diese beiden Wissenschaftler führen zudem unter anderem an, dass es keine gemeinsamen physikalischen Gesetze zwischen dem Erwärmungsphänomen in einem Glasgewächshaus und dem fiktiven atmosphärischen Treibhauseffekt gibt.

So gibt es immer wieder mutige Wissenschaftler, die riskieren von den Medien und Politikern öffentlich mit unbewiesenen Behauptungen angegriffen zu werden, weil Fakten geleugnet und Naturgesetze ignoriert werden. Übereinstimmungen in der Vorgehensweise der Inquisition im Mittelalter und unserer heutigen Regierung sind keineswegs zufällig, sondern traurige Wirklichkeit. Fakten sind aber aus wissenschaftlicher Sicht das Todesurteil jeder Theorie.

Dennoch hindert das weder die Printmedien, noch die angeblich unabhängigen Rundfunk- und Fernsehanstalten, den Menschen die Erderwärmung weiterhin durch CO2 zu suggerieren, anstatt darauf hinzuweisen, dass der Klimawandel nicht durch den Menschen zu beeinflussen ist.

Jeder interessierte Bürger konnte wiederholt bei den unterschiedlichen Fernsehdokumentationen im Privatfernsehen über die Entstehung von Wüsten, insbesondere der Sahara, lesen, sehen und hören, dass als Ursache für deren Klimawandel eine geringgradige Veränderungen der Neigung der Erdachse zur Sonne bw. eine leichte Veränderung der Bahnebene der Erde um die Sonne angesehen wird, was eine unterschiedlich intensive Sonneneinstrahlung auf unseren Planeten zur Folge hatte. Bei öffentlich-rechtlichen Rundfunk- und Fernsehanstalten habe ich dergleichen noch nie wahrgenommen. Spätsendungen, wenn die arbeitende Bevölkerung ihre verdiente Nachtruhe genießt, will ich aber nicht gänzlich ausschließen. In einem derartigen Fall muss man zwar nicht gleich von „Lügenpresse“ sprechen, aber unter seriösem Journalismus versteht man eigentlich etwas anderes. Auch „Zensur“ ist vielleicht ein zu starkes Wort, aber „gelenkte Information“ dürfte die passende diplomatische Formulierung sein.

Die Behauptungen über die angebliche Versauerung der Weltmeere durch CO2 braucht man ebenfalls nicht ernst zu nehmen. Die Vertreter dieses Horrorszenariums verschweigen nämlich, dass einige 100 Millionen Jahre vor unserer Zeitrechnung sich die damaligen Meereslebewesen vom Kambrium bis zur Kreidezeit, also vor rund 540 bis etwa 65 Millionen Jahren, trotz eines bis zu 20fach höheren CO2-Gehalts bester Gesundheit erfreut haben. Überall auf der Erde beweisen zahllose, teils hunderte von Metern dicke Kalk- und Kreideschichten, dass die Meereslebewesen imstande waren, gesunde und vollständige Kalkskelette auszubilden. Die Geologie beweist dies in Form gut erhaltener Kalkfossilien in nahezu unendlichen Stückzahlen. Rund 80% der gesamten Kohlenstoffvorräte der oberflächennahen Zonen der Erde sind heutzutage in Form von Kalkstein und Dolomit gebunden. Aber das wird alles totgeschwiegen.

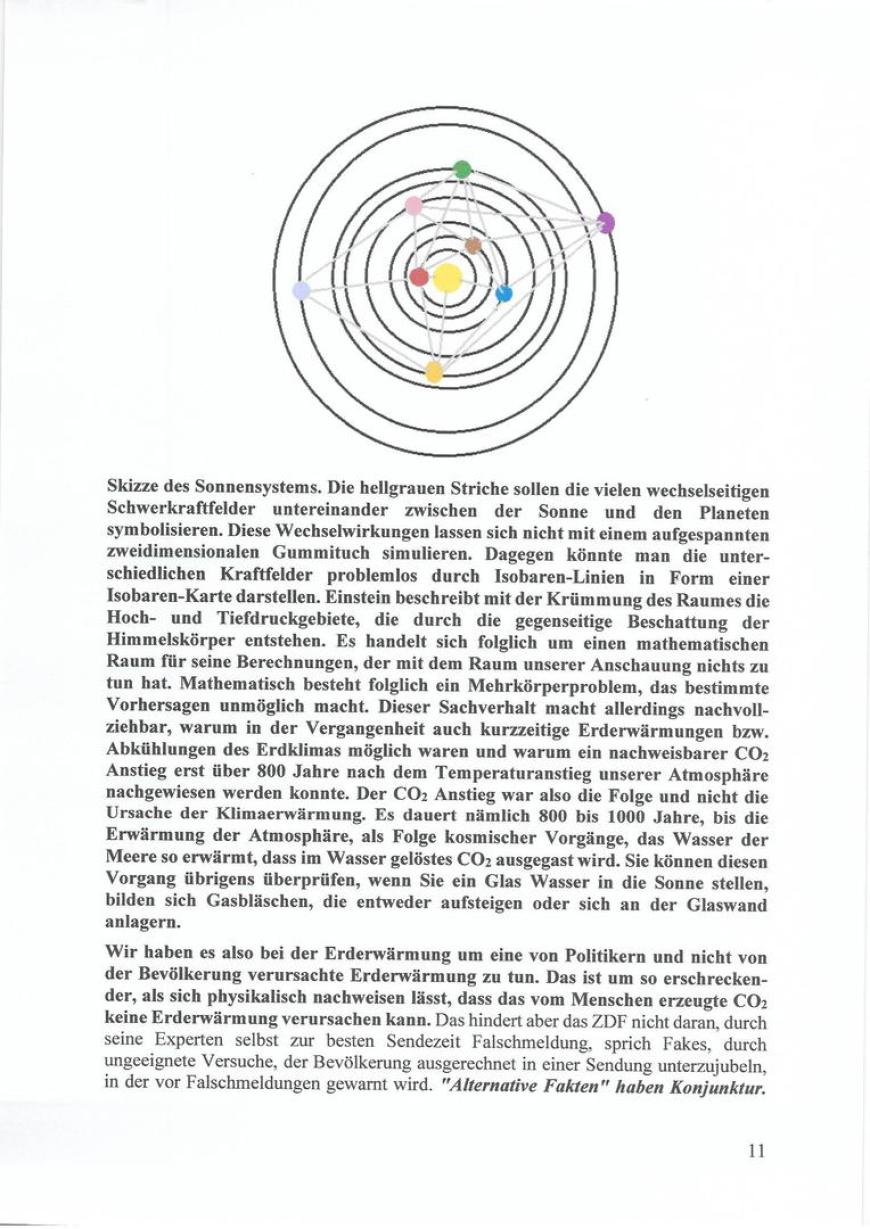

Tatsache ist, dass das Klima unseres Planeten nicht durch CO2 beeinflusst wird, sondern durch kosmische Einflüsse, die für die Neigung der Erdachse, der Umlaufebene und die Sonnenaktivität verantwortlich sind.Während die Planeten um die Sonne kreisen, üben sie u.a. auch gegenseitig gravitative Kräfte aufeinander aus, was zur Folge hat, dass nicht nur in den großen Zeiträumen, in denen die Erdachse ihre Neigung und Umlaufebene zur Sonne deutlich und langfristig verändert, anhaltende Klimaveränderungen (wie z.B. die langen Eiszeiten auf unserem Planeten) auftreten, sondern dass bereits kleinere, kurzfristige Schwankungen der Erdachsenneigung und/oder der Erdumlaufbahn ebenfalls zu vorübergehenden Klimaveränderungen, wie die zur Zeit zu beobachtende Klimaerwärmung, führen können.

So lassen sich die Wechsel zwischen den Eiszeiten und Warmphasen der vergangenen ein bis zwei Millionen Jahre auf kleine periodische Schwankungen in der Erdbahn um die Sonne zurückführen, die sich jedoch, da es sich um ein Vielkörperproblem handelt, nicht im Voraus berechnen lassen. In diesem Zusammenhang sei auf die „kurze Eiszeit“ im Mittelalter hingewiesen, die als Folge einer kurzfristigen Neigungsveränderung der Erdachse zur Sonne anzusehen ist und auf die Desertation der Sahara vor etwa 8000 Jahren, die durch eine Veränderung der Bahnebene der Erdumlaufbahn um die Sonne entstanden sein dürfte und deshalb langfristige Auswirkungen das Klima hat.

Übrigens gibt es zwischenzeitlich Spezialkameras, die auch schon industriell genutzt werden, um CO2 sichtbar zu machen. Sogar Atemluft lässt sich nachweisen (19.11.2016; www.spiegel.de; Wissenschaft, Natur, Klimawandel. CO2: Spezialkamera macht Kohlendioxid sichtbar). Wenn diese Kamera auf einen bestimmten Wellenmengenbereich im Infraroten, in dem CO2 Wärmestrahlung absorbiert wird, gerichtet wird, kann man CO2 als dunkle Kontrastwolke vor dem Hintergrund erkennen.

Die Erklärung, aus welchem Grund der CO2 – Anstieg erst etwa 800 Jahre nach einer beginnenden Erderwärmung auftritt, ist die Erkenntnis seriöser Wissenschaftler, die nicht bereit sind, sich dem weltweiten Mainstream unterzuordnen. Dass CO2 im Wasser gebunden wird, kann jeder beim Öffnen einer Mineralwasserflasche erkennen, wenn sich die Gasblasen bilden und unterschiedlich schnell aufsteigen. Nun ist die Lösung von CO2 im Wasser nicht nur von der jeweiligen Temperatur abhängig, sondern auch von den jeweiligen Druckverhältnissen. Wenn sich also die Meere erwärmen, setzen sie gelöstes CO2 in Form von Gasblasen frei. Dieser Vorgang führt aber gleichzeitig wieder zu einer Abkühlung, wie jeder, der schon einmal geschwitzt hat, sich erinnern dürfte. Beim Sinken der Umwelttemperaturen löst sich wieder mehr CO2 im Wasser und der CO2-Wert sinkt wieder. Der gleiche Effekt ist während der unterschiedlichsten Vegetationsphasen zu beobachten. Das ist auch der Grund, weshalb sich die Erde wieder abkühlen konnte, obwohl sich in der Atmosphäre ungleich höhere CO2 Konzentrationen als heute nachweisen ließen.

Wenn sich trotzdem unsere Bundeskanzlerin Merkel, eine promovierte Physikerin, von „Experten“ umgibt, die glauben, sich über Naturgesetze hinwegsetzen zu können, dann machen wir uns nicht nur lächerlich, sondern fallen wieder in das Mittelalter zurück.

Die Befürworter der CO2 - Reduzierung argumentieren hier folgendermaßen: Weil es zu dieser oder jener Zeit weltweite Temperaturerhöhungen gab, muss dieser Temperaturanstieg auf die damals herrschenden CO2-Werte bezogen werden. Man benutzt also Temperatur- und CO2-Werte aus der Vergangenheit zum Beweis der anthropogenen Klimaerwärmung, ohne den Beweis erbracht zu haben, dass ein Zusammenhang zwischen diesen beiden Werten besteht. Schließlich kommt es gerade auf den Temperaturverlauf und seine Übereinstimmung mit dem Kohlendioxidgehalt in der Vergangenheit an. Wenn sich diese angebliche Übereinstimmung in der Vergangenheit nicht zeigt - und sie tut es nicht -, dann bricht die ganze Theorie des vom Menschen gemachten Treibhauseffektes wie ein Kartenhaus in sich zusammen. Schließlich behauptet heute wohl kaum ein Mensch, dass der Geburtenrückgang in Deutschland damit zusammenhängt, dass die Zahl der Störche ebenfalls rückläufig ist.

Zu den Klimaverhältnissen in der Antarktis schreibt das Umweltbundesamt unter:

www.umweltbundesamt.de/themen/.../antarktis/die-antarktis/das-klima-der-antarktis:

„Die sehr niedrigen Temperaturen in der Antarktis gehen im Wesentlichen auf den geringen Eintrag von Strahlungsenergie zurück. Im Südsommer – wenn auf der Nordhalbkugel Winter herrscht – ist der Südpol zur Sonne geneigt und es herrscht 24 Stunden lang Tag. Wegen der Schiefe der Ekliptik, also der Neigung der Erdachse von 23,5° zur Ebene ihrer Umlaufbahn um die Sonne, treffen die Sonnenstrahlen selbst im Südsommer nur sehr flach auf die Oberfläche der Antarktis. Zusätzlich besitzt der Schnee ein starkes Reflektionsvermögen (Albedo), so dass die Sonnenenergie zum größten Teil gar nicht aufgenommen wird und die Wärmeabstrahlung größer als die Sonneneinstrahlung ist (negative Strahlungsbilanz der Antarktis). Selbst im Südsommer bei ganztägiger Sonneneinstrahlung erwärmt sich die Antarktis nicht nennenswert. Im Südwinter (Nordsommer) herrscht am Südpol wegen der Neigung der Erdachse von der Sonne weg 24 Stunden lang Nacht, so dass keine Sonnenstrahlung den Kontinent erwärmt.“ Ende des Zitates.

Es lässt sich also durchaus nachvollziehen, warum das Eis in der Arktis schneller schmilzt als in der Antarktis und man bekommt gleichzeitig eine Vorstellung, welche Bedeutung eine Abweichung der Neigung der Erdachse zur Sonne hat.

Heute weiß man, dass nicht nur die Sonne und die Erde exzentrische Schwerpunkte haben, was allein schon bei der Berechnung der Erdachsenneigung auf ihrer Umlaufbahn um die Sonne Probleme bereitet, nein, auch der Mond und die anderen Planeten wirken auf unsere Erde und letztlich auch auf die Sonne ein. Das führt dazu, dass die Erde auf ihrer Umlaufbahn förmlich um die Sonne eiert. Die Mathematiker haben es folglich mit einem unbewältigten mathematischen Mehrkörperproblem zu tun und können deshalb nur bestätigen, dass, wie bereits erwähnt, die Erdachse und die Bahnebenen sich nicht nur in großen Zyklen, sondern auch permanent unterschiedlich stark in Form von kleineren Abweichungen verändern, sich also quasi chaotisch verhalten. Dies führt zwangsläufig zu unterschiedlich intensiver und unregelmäßiger Sonneneinstrahlung auf unseren Planeten und hat die schon lange bekannten und nachgewiesenen Klimaveränderungen zur Folge.

Diesen Sachverhalt kann jeder leicht überprüfen, wenn er verfolgt, wie sich die Temperatur mit dem jeweiligen Sonnenstand verändert. Aus diesem Grunde ist es zu Mittag am wärmsten, wenn die Sonne am höchsten steht. Die Erde umrundet die Sonne in einer quasi chaotischen Umlaufbahn in unterschiedlicher Entfernung. Da es sich um ein multifaktorielles Problem handelt, lassen sich auch keine hinreichend genauen bzw. längeren Vorhersagen machen.

Am Montag, den 8. Juni 2015 berichtete der General-Anzeiger aus Bonn ausführlich über die Klimaerwärmung und ihre möglichen Ursachen, da Herr Thomas Litt, Professor für Paläobotanik am Steinmann-Institut in Bonn und Leiter des Internationalen Forscherkonsortiums Paleovan, die Ergebnisse seiner aktuellen Forschertätigkeit im Fachmagazin „Quaternary Science Reviews“ in mehreren Artikeln veröffentlicht hatte. Er führte in dem in der Osttürkei liegenden Vansee, der siebenmal so groß wie der Bodensee ist, fünf Jahre lang Erdkernbohrungen durch. Die Auswertungen des Sedimentes in den Bohrkernen ergaben eindeutige Ergebnisse. Das Sediment dieses Sees, das, was allgemein anerkannt ist, wegen seiner Lage und seines Alters die Vorgänge in der Umwelt seit Urzeiten in seinen Sedimentschichten gespeichert hat, „informiert“, vergleichbar den Seiten eines Buches, über alle Veränderungen in der Zeitspanne seines Bestehens. Der lückenlose Kalender umfasst insgesamt sechs Zyklen aus warmen und kalten Perioden und erzählt eine Geschichte der natürlichen Klimaschwankungen, die zeitlich synchron zu den periodischen Schwankungen der Erdbahn um die Sonne verlaufen. Es ist weitgehend unstrittig, dass die CO2-Werte um 122 Moleküle bei 1 000 000 Luftteilchen in den letzten 150 Jahren angestiegen sind. Es ist auch unbestritten, dass dieser Anstieg weitgehend von den Menschen verursacht wurde. Es ist aber keineswegs bewiesen, dass der geringe CO2-Anstieg eine Erderwärmung zwischen 1 und 2 Grad Celsius verursacht hat. Hier handelt es sich vielmehr um ein zufälliges Zusammentreffen zweier Vorgänge, die nichts miteinander zu tun haben, aber so wird es, aus welchen Gründen auch immer, den Leuten eingeredet. Auf Grund der oben beschriebenen Tatsachen sind Erdkernbohrungen ein ideales Klimaarchiv und lassen Rückschlüsse auf die Klimaverhältnisse auf unserem Planeten während mehrerer Jahrhunderttausende zu.

Professor Litt schreibt u. a.: „Die Ergebnisse zeigen, dass das Klima in den vergangenen Hunderttausenden Jahren auf der Nordhalbkugel Achterbahn gefahren ist. Innerhalb weniger Jahrzehnte konnte es kippen und von Eiszeit auf Warmzeit und umgekehrt umschalten.“ Ende des Zitates.

Unsere Bundeskanzlerin, eine promovierte Physikerin, ignoriert nicht nur die Argumente ihrer Kollegen, sondern auch die anderer Wissenschaftszweige, die die gesamte Irrlehre von der Erderwärmung durch CO2 ad absurdum führen. Wenn sich aber eine Bundeskanzlerin, die ja bekanntlich die Richtlinien der Politik bestimmt, über Naturgesetze hinwegsetzt, indem sie nicht dem logischen Denken und dem Sachverstand seriöser Wissenschaftlern, sondern dem Mainstream folgt, um durch Mehrheitsmeinungen, welche von den Medien durch entsprechende Berichterstattungen befeuert werden, bestimmte Interessen durch-zusetzen, werden nicht nur sinnlose Unsummen an Steuergeldern „verbrannt“, dann ist auch die Demokratie in Gefahr, weil auf diese Weise abweichende Meinungen von der bestimmenden Kanzlerinnenmeinung als unbedeutende Spinnereien abgetan werden. Für mich ist unter diesen Bedingungen auch nicht nachvollziehbar, warum Politiker öffentlich einen Amtseid ablegen.

Ende 2015 haben sich die Regierungsvertreter von über 190 Ländern, also fast der gesamten Weltgemeinschaft, auf der internationalen, in Paris stattfindenen Klimaschutzkonferenz erneut darauf geeinigt, alles daran zu setzen, die Erderwärmung durch Drosselung der CO2-Produktion auf höchstens 2 und möglichst auf 1,5 Grad zu begrenzen. Dieses kostspielige globale Abkommen, welches auch von China und der USA (noch unter Obama) ratifiziert wurde, hat zwar keinen Einfluss auf die Klimaerwärmung, führt aber bei seiner Umsetzung in diesen Ländern zwangsläufig zu enormen Fehlinvestitionen, also „verbrannten Steuergeldern“, die an anderer Stelle dringend benötigt werden.

Allgemein erkennbar leben Politiker und ein Großteil ihrer Berater in einer Welt der Kompromisse, des Kuhhandels, der Konsensmeinungen, Meinungsmache und Mehrheitssuche. Jeder versucht seine Position zu verteidigen und zu festigen. Unter diesen Voraussetzungen ist der aktuelle Rundumschlag des US-Präsidenten Trump bezüglich des Klimawandels eine wohltuende Intervention, denn wer alles negiert, schafft nach den Erkenntnissen der Chaosforschung die Chance eine neue Ordnung entstehen zu lassen. In der Fischwirtschaft würde man von einem Hecht im Karpfenteich sprechen. Er ist ein übliches Mittel, die trägen Karpfen in Bewegung zu halten, damit sie Muskelfleisch entwickeln. Besonders im 19. Jahrhundert wurde diese Redewendung viel in der politischen Satire und Karikatur gebraucht und auf verschiedene Herrscherfiguren (Napoleon III., Bismarck u. a.) angewendet.

Die zur globalen Verminderung der CO2 -Emissionen vorgesehenen riesigen Summen sollten, anstatt sie sinnlos zu vergeuden, besser und wirkungsvoll sowohl zur Minderung der durch den unbestrittenen Klimawandel bereits eingetretenen sowie der zukünftigen Schäden und zur weitgehenden Reduzierung von Luftschadstoffen verwandt werden, denn alle Menschen brauchen weltweit dringend saubere Luft, reines Trinkwasser und gesunde Böden und Meere. Es ist erschreckend, wie man seriöse Wissenschaftler wirkungsvoll mundtot macht und ihre vorausschauenden Warnungen missachtet. Außerdem wäre es immens wichtig, so schnell wie möglich umfangreiche bauliche und andere wichtige Maßnahmen zu ergreifen, um gegen die Folgen zukünftiger Naturkatastrophen besser gewappnet zu sein.

Saurer Regen wird durch Verteilung der Schadstoffemissionen in der Atmosphäre infolge von Luft-strömungen häufig in weit entfernten Regionen verbracht. Das bedeutet, dass der Verursacher und der Empfänger von saurem Regen oft verschiedene Staaten sind. Durch die Luftverschmutzung kommt es zur Wasserbelastung und Bodendegradation, bei denen es sinnvoll ist, aufgrund der Gemeinsamkeiten die Ursachen oder Folgen als ein System zu begreifen. So werden Bäche, Flüsse, Seen und Küstenregionen durch den sauren Regen geschädigt. In Schweden etwa waren einzelne Seen so versauert, dass sie ohne jegliches Leben waren. Sie hatten teilweise einen pH-Wert von weniger als 3, waren also in etwa so sauer wie Haushaltsessig. Wie oben berichtet wurde, kann ein derart saurer Regen nicht durch den hohen Ausstoß von Kohlenstoffdioxid entstehen. Verantwortlich für einen pH-Wert des Wassers unter 5,6 müssen andere chemische Verbindungen sein. Die Schadstoffe, die für den sauren Regen verantwortlich sind, sind Stickstoffmonoxid, Stickstoffdioxid, Schwefeldioxid und Phosphorverbindungen.

Diese Verbindungen bilden die stärksten Säuren und vernichten im Wasser und in den geschädigten Böden viele Mikroorganismen, was wiederum eine Verschlechterung der Wasser- und Bodenqualität zur Folge hat. Die oben angeführten Verbindungen kommen zwar auch ohne das Zutun des Menschen in der Natur vor: Z.B. entstehen Stickstoffoxide bei Zersetzungsprozessen im Boden und Schwefeloxide werden von Vulkanen freigesetzt. Diese gasförmigen Oxide reagieren mit den Wassermolekülen in der Luft und bilden so den sauren Regen. Die Hauptmenge dieser Schadstoffe wird jedoch vom Menschen erzeugt und ausgestoßen, vor allem bei der Verbrennung von fossilen Brennstoffen in Kraftwerken, Haushalten und Verkehr, obwohl man auch hier mit geeigneten Maßnahmen Abhilfe schaffen könnte: Der vom Menschen produzierte Rauch besteht aus einem Gemisch unterschiedlichster fester Teilchen in einer gasförmigen Phase und kann zusammen mit Ruß beträchtliche Umwelt- und Gesundheitsschäden bei Menschen, Tieren und Pflanzen verursachen. Es wäre folglich viel sinnvoller diese Umweltgifte zu eliminieren oder wenigstens stark zu reduzieren, da durch sie aktuell ein größerer Schaden verursacht wird, als von dem angeblichen Klimakiller CO2 je zu erwarten ist.

Wasserdampf ist das wichtigste natürliche Treibhausgas. Da der Wassergehalt in der Luft von der Temperatur abhängig ist, nimmt der Gehalt an Wasserdampf in der Atmosphäre mit steigenden Temperaturen zu und verstärkt damit die Auswirkungen anderer Treibhausgase.

Ein Kubikmeter Luft kann bei folgenden Umgebungstemperaturen maximalnachstehend angegebenenGramm Wasser aufnehmen:

0°C ca. 5g Wasser

10°C ca. 9g Wasser

20°C ca. 17g Wasser

30°C ca. 30g Wasser

40°C ca. 50g Wasser

50°C ca. 80g Wasser

60°C ca. 120g Wasser

80°C ca. 300g Wasser

Stark erhöhte Luftschadstoffkonzentrationen als Folge von allen möglichen Emissionen verursachen nicht nur nebelartige Dunstglocken, den sogenannten Smog, sondern führen auch zu erheblichen Gesundheitsschäden. Durch entsprechende Filter sowie chemische und physikalische Trennungsverfahren kann man diese Luftverschmutzung in den Griff bekommen, wenn man nur entsprechende Geldmittel locker macht. Ein Eindrucksvolles Beispiel effektiver Bekämpfungsmaßnahmen sind die Neuen Bundesländer. Wenn man also weltweit derart fahrlässig mit der Reinhaltung der Luft umgeht, werden Millionen von Menschen an den Schadstoffen in der Luft sterben, bevor sie die durch die Folgen einer fiktiven, durch CO2 verursachten Erderwärmung Schaden erleiden.

Doch nach wie vor werden Naturgesetze ignoriert und der in den letzten Jahren ansteigende CO2 - Gehalt der Atmosphäre weiterhin als der „Klimakiller“ dargestellt, dessen „Freispruch“ aus wirtschaftlichen und/oder politischen Interessen für die Regierenden der meisten Länder nicht in Frage kommt, weil sie, wie die meisten Menschen, bedenkenlos den Behauptungen der von dem Establishment und den Lobbyisten geförderten und von den Medien ins öffentliche Rampenlicht gehobenen, wie „Gurus“ auftretenden „Klimaexperten“ mehr Vertrauen schenken, als den auf exakten Untersuchungsergebnissen basierenden Aussagen der zahlreichen seriösen aber „totgeschwiegenen“ Wissenschaftlern. Im Internet sind zahlreiche seriöse Veröffentlichungen von Wissenschaftlern nachzulesen, die nicht bereit sind, dem Mainstream zu folgen, aber von mächtigen Interessensgruppen im günstigsten Fall als „Klimaskeptiker“ disqulifiziert und ins Abseits gestellt werden.

Trotz Fukushima haben auch die japanischen Regierungsvertreter offensichtlich nichts dazu gelernt. So kann man im Internet (unter http://www.spiegel.de/wissenschaft/technik/fuenf-jahre-fukushima-japans-ungenutzte-chance-a-1081070.html. ( geschrieben: Freitag, den 11.03.2016, 11:38 Uhr) den folgenden Beitrag finden: „Zusammengefasst: Umfragen zufolge lehnt die Mehrheit der Japaner den nuklearen Neustart ab. Doch fünf Jahre nach der dreifachen Kernschmelze von Fukushima zeigt die Atomlobby keine Reue. Langfristig will das Land zwar nur noch ein Fünftel des Stroms aus Kernenergie erzeugen. Doch die Atombosse möchten so schnell wie möglich weitere Kernkraftwerke wieder hochfahren, die nach dem Desaster von 2011 zeitweise abgeschaltet worden waren.“ Ende des Zitates.

Da trifft es sich gut, dass gerade in einer derart verfahrenen Situation die Asahi Glass Foundation in Japan den renommierten Blue Planet Prize, kurz vor dem G20 – Gipfel in Hamburg im November dieses Jahres, rein zufällig, den Blue Planet Prize an Hans Joachim Schellnhuber, einen vehementen Vertreter der CO2 – Klimalüge, vergibt, der als PIK-Direktor weitreichende Einflussnahme auf die internationale Klimapolitik hat und u.a. auch unsere Bundeskanzlerin Frau Dr. phil. nat. Angela Merkel berät, welcher politische Entscheidungen offensichtlich ebenfalls wichtiger als Naturgesetze sind. Honi soit qui mal y pense.

Auf der Suche nach Lösungen und Ideen, welche langfristig von direktem oder indirektem gesellschaftlichen Nutzen sind, braucht die Klimapolitik wissenschaftliche Beratung durch unabhängige und neutrale Wissenschaftler. Die Rollen von Wissenschaft und Politik müssen allerdings klar definiert und getrennt bleiben. Das ist aber praktisch unmöglich, da die Politik einerseits die nötigen finanziellen Mittel bereitstellt und verteilt und andererseits die auch „Scientific Community“ genannte Wissenschaftsgemeinde, über ein interessengesteuertes gut funktionsfähiges eigenes weltweites Netzwerk verfügt, in dem auch die Weichen für Karrieren gestellt werden und man mit den Wölfen heulen muss, will man die eigene Protektion innerhalb der Wissenschaften aufbauen.

Doch erfreulicher Weise eröffneten sich im Laufe der Menschheitsgeschichte immer wieder Zeitfenster, die zu entscheidenden Paradigmenwechseln führten. Schließlich blieb unser Planet trotz aller Widerstände auch nicht für alle Zeiten eine flache Scheibe und das Zentrum des Universums. Jedoch brauchte solch ein Vorgang stets Zeit und viele Opfer. In unserer so schnelllebigen Gegenwart wird man nicht von heute auf morgen umdenken. Die Konzerne sind zu einflussreich und die Öffentlichkeit zu passiv und zu gutgläubig. Immerhin dauerte es fast 2500 Jahre, bis die Erkenntnisse des griechischen Astronomen und Mathematikers Aristarchos von Samos, dass die Erde um die Sonne kreist, unser Planet eine kugelförmige Gestalt besitzt und die Jahreszeiten nur durch die Neigung der Erdachse zur Sonne erklärt werden können, allgemein akzeptiert wurden.

Unter den derzeitigen Umständen wird die Menschheit allerdings nicht noch einmal so viel Zeit zum Überlegen haben, da sie sich zuvor selbst eliminieren wird.

©

==============================================================================================================

Kosmologie in der Sackgasse.

Die Theorie wie der Kosmos entstand, wird von dem wissenschaftlichen Establishment mit einem Enthusiasmus verteidigt, der dem blinden Glauben und religiösen Eifer der Kirche im Mittelalter nicht nachsteht. Inkompetenz, Intoleranz und Arroganz der tonangebenden Vertreter einer theoretischen Physik, die an Esoterik erinnert, gehen erbarmungslos gegen Kritiker vor. Der Physiker und Nobelpreisträger Martinus Veltman kam 1961 als junger holländischer Physiker ans Cern. Er beschreibt die Situation der Physiker auf die Frage eines Journalisten der Zeit (DIE ZEIT 23.09.2004 Nr.40), ob es stimmt, dass der Umgang unter Physikern wenig zimperlich ist: „Physiker sind anarchistische Naturen. Man kann sie mit nervösen Rennpferden vor dem Start vergleichen. Sie haben ein ausgeprägtes Gefühl für Konkurrenz. Aber wie überall ist das eine Frage des Charakters. Bei gewissen Leuten muss man vorsichtig sein, was man sagt, sonst erhält man umgehend die Quittung.“

In der Kosmologie gibt es zwei Grundwahrheiten.

1. Die Wissenschaftslobby hat immer Recht

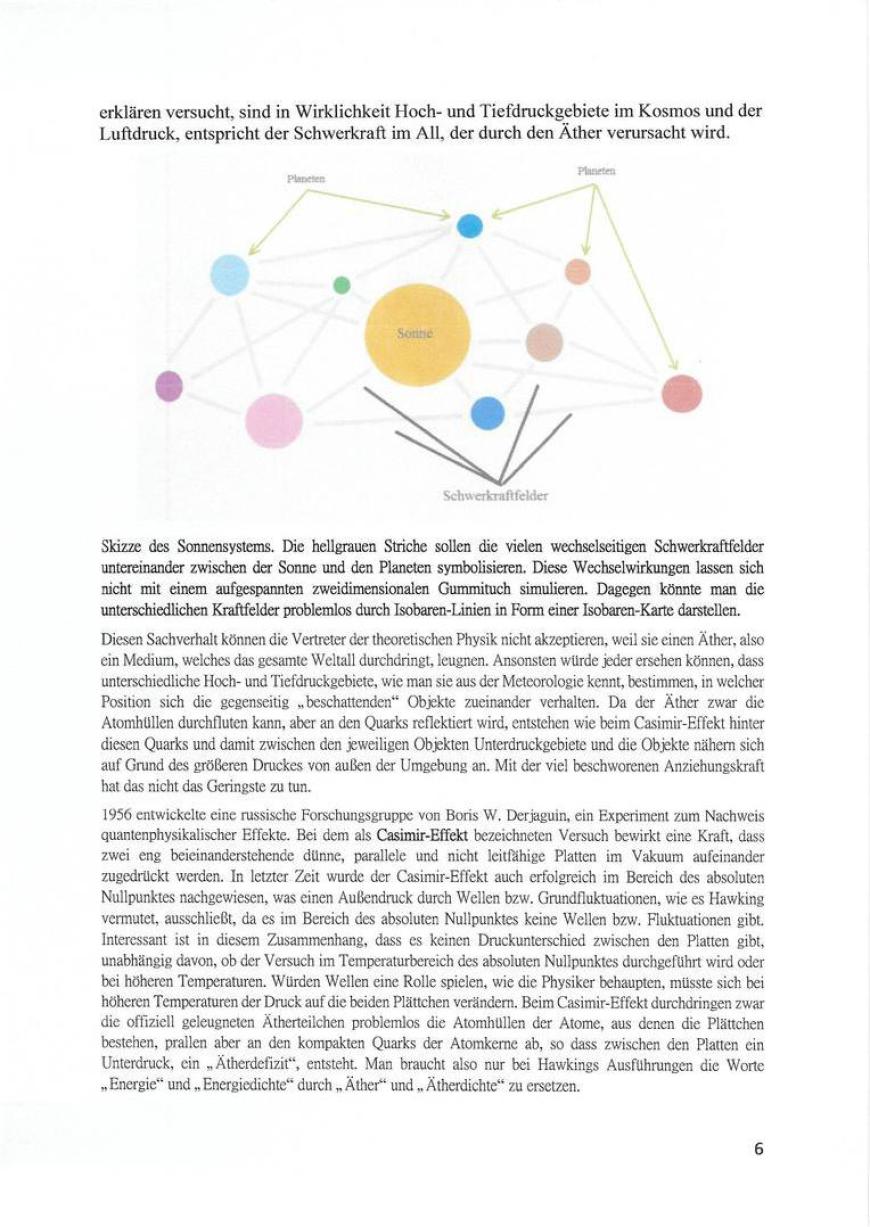

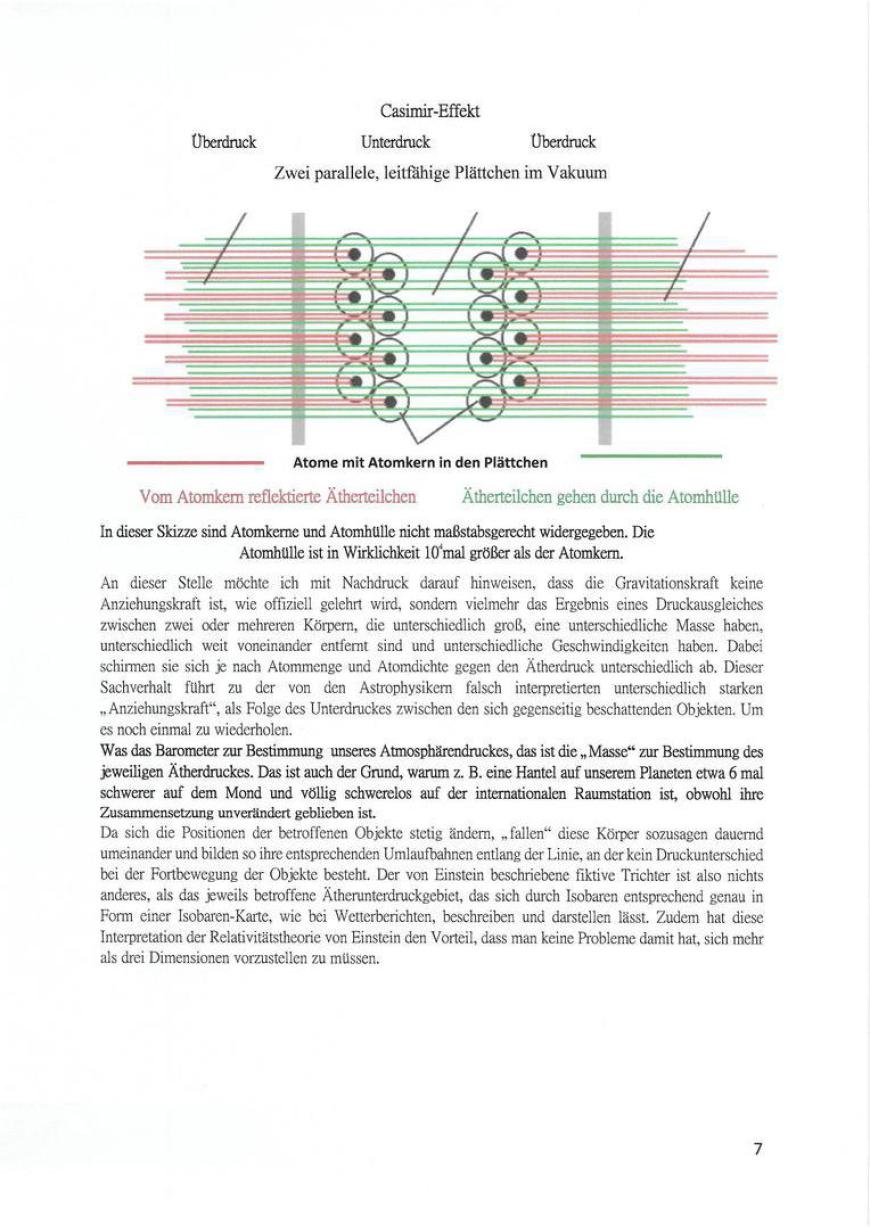

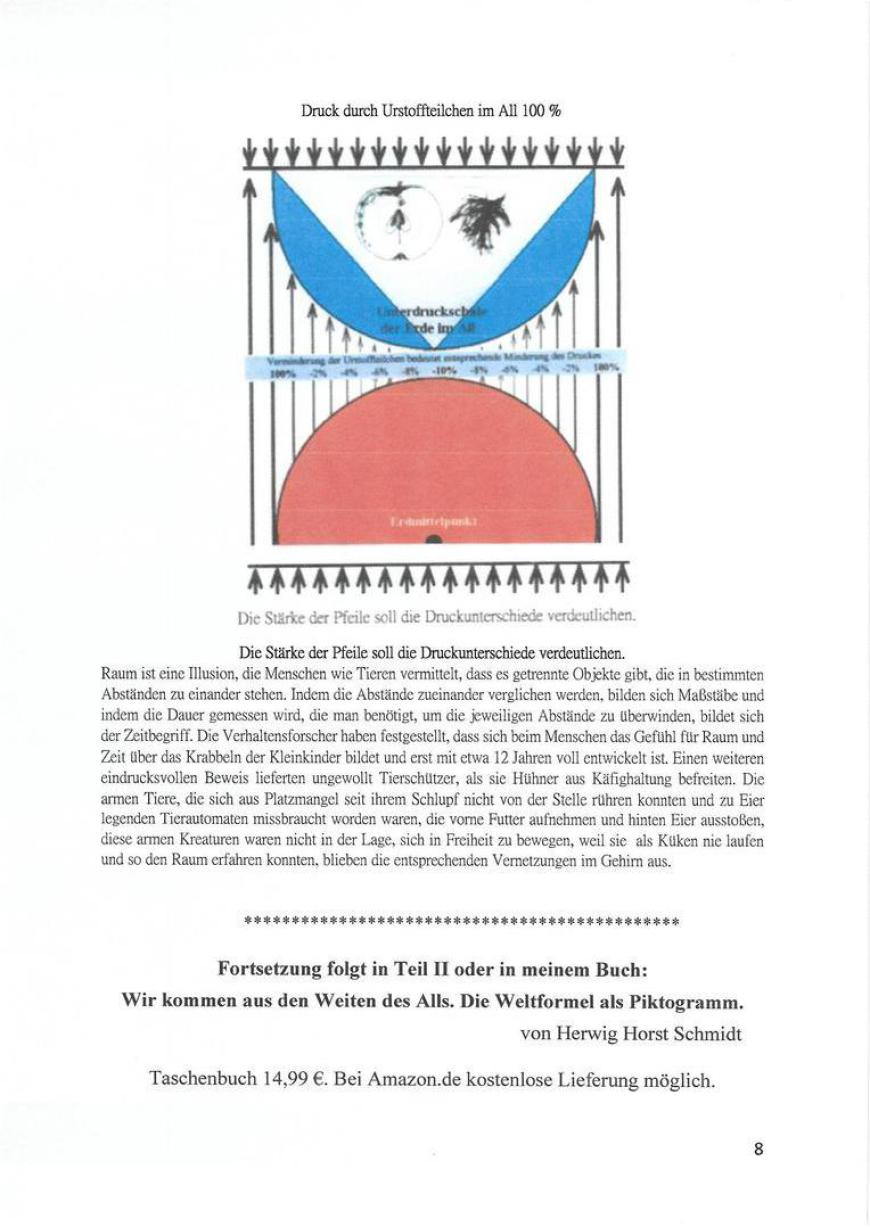

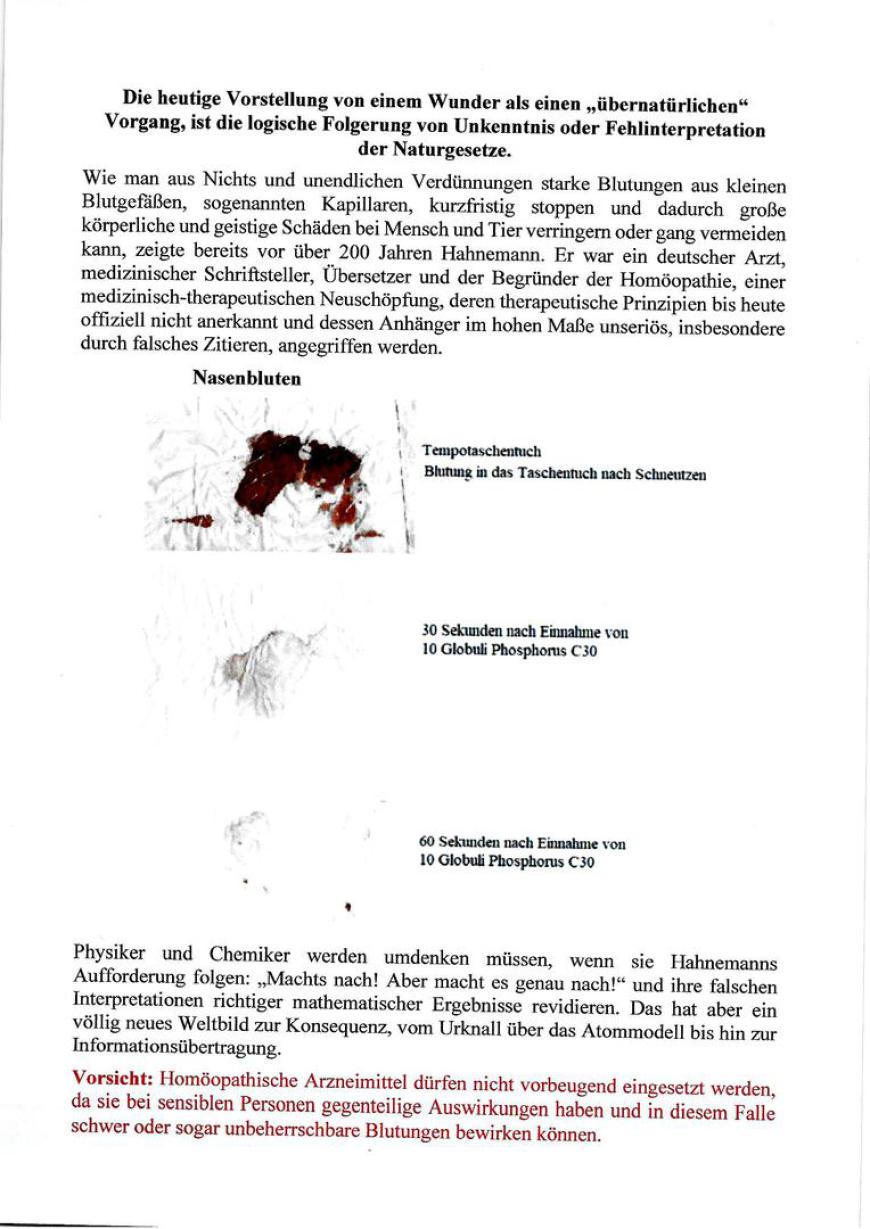

2. Das Universum entstand durch einen Urknall